Initial commit

Signed-off-by:  lijian <lijian6@sugon.com>

lijian <lijian6@sugon.com>

parents

Showing

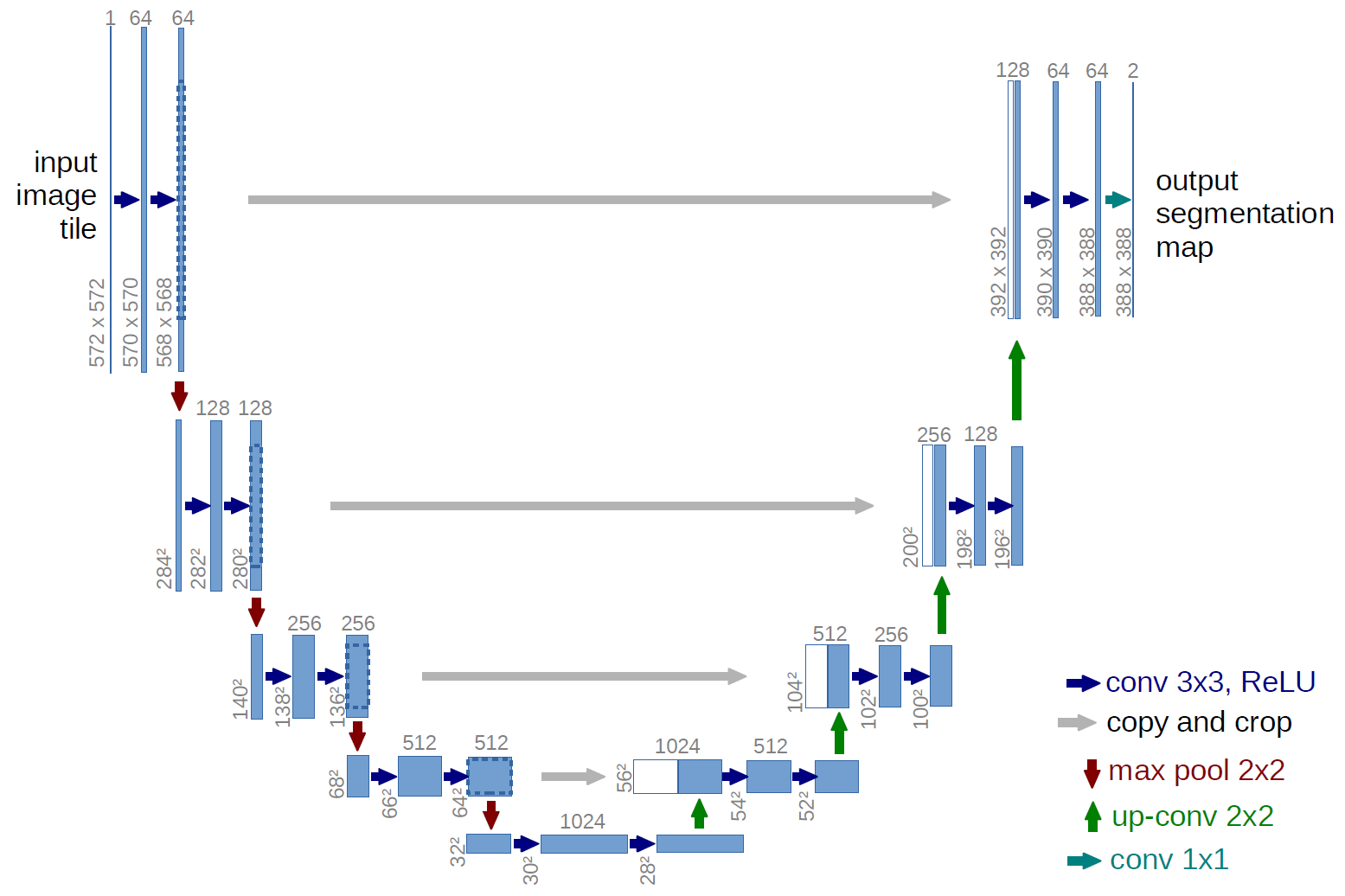

Doc/Images/Unet_Image_1.png

0 → 100644

101 KB

17.2 KB

17.2 KB

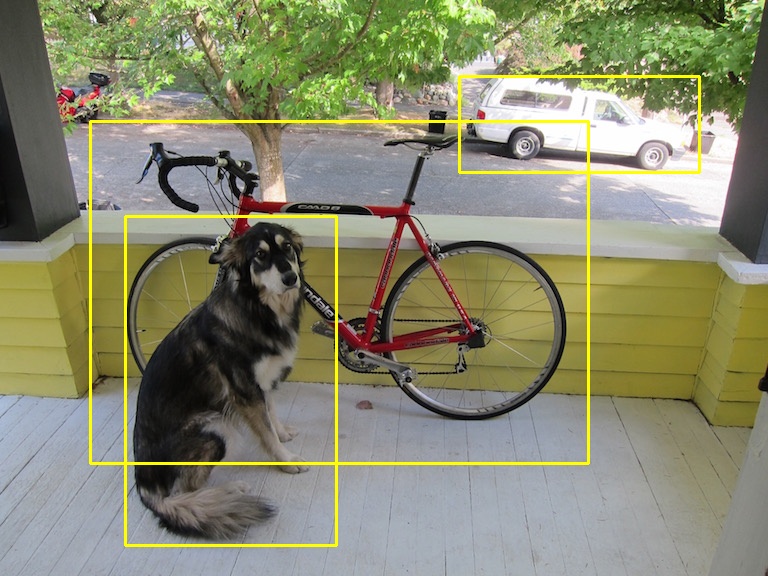

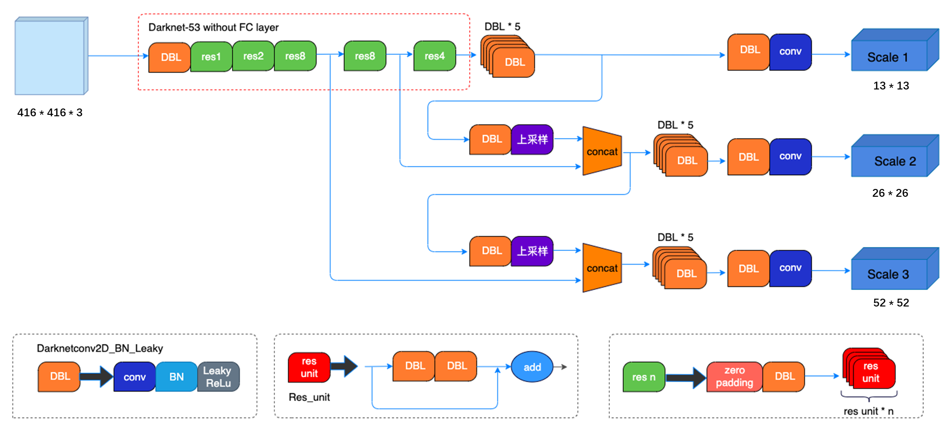

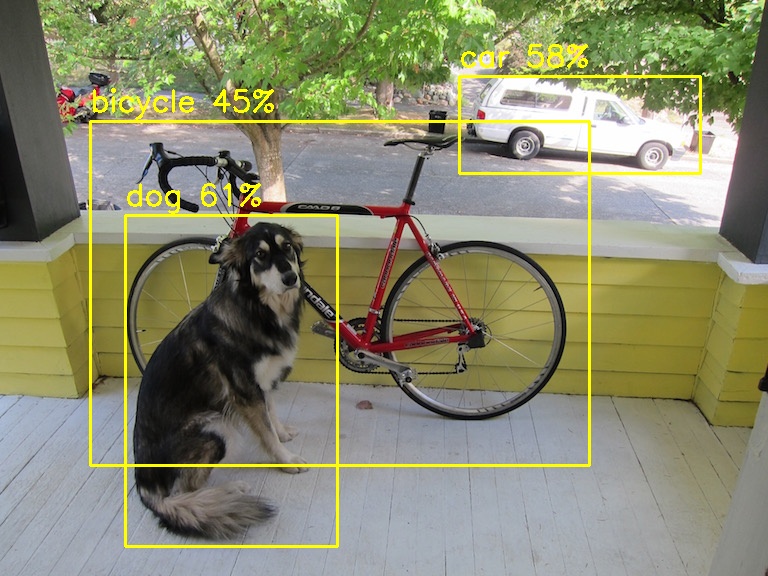

Doc/Images/YOLOV3_01.jpg

0 → 100644

181 KB

Doc/Images/YOLOV3_02.jpg

0 → 100644

96 KB

Doc/Images/YOLOV3_03.jpg

0 → 100644

183 KB

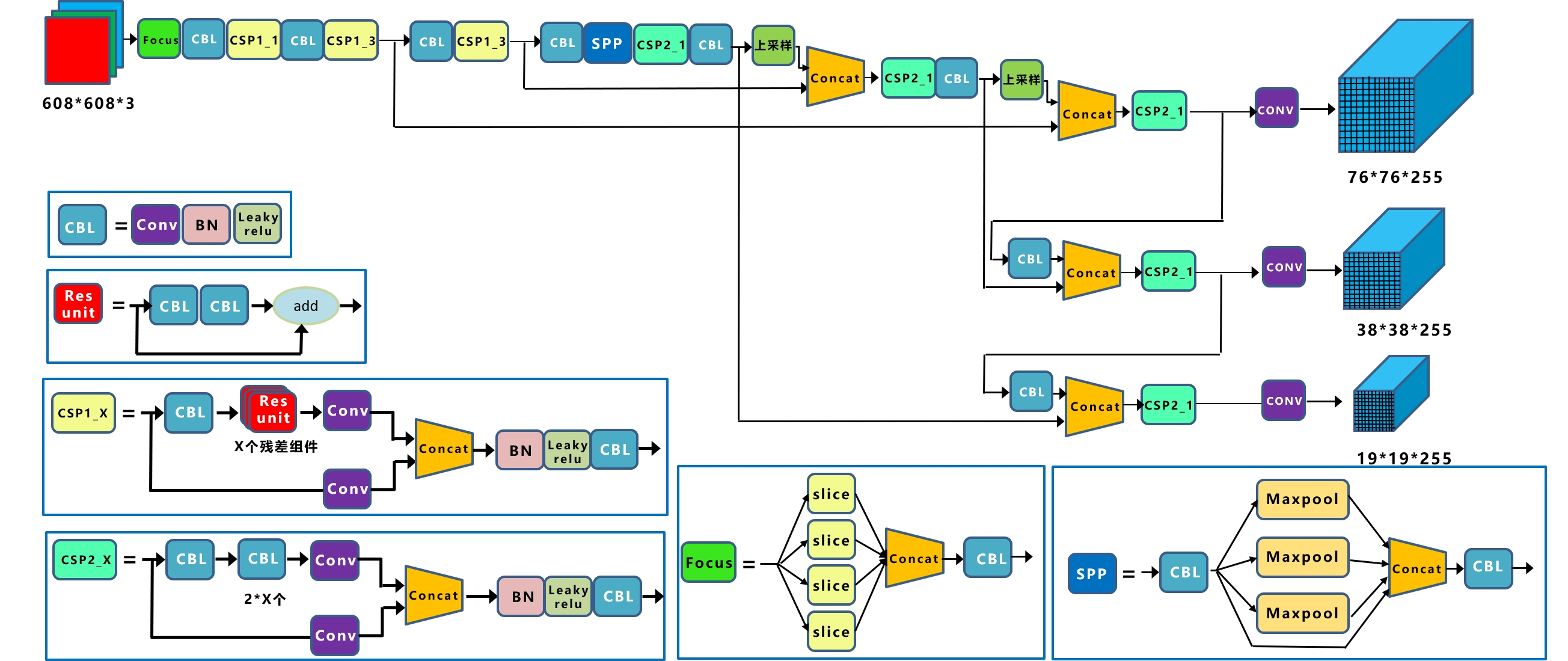

Doc/Images/YOLOV5_01.jpg

0 → 100644

571 KB

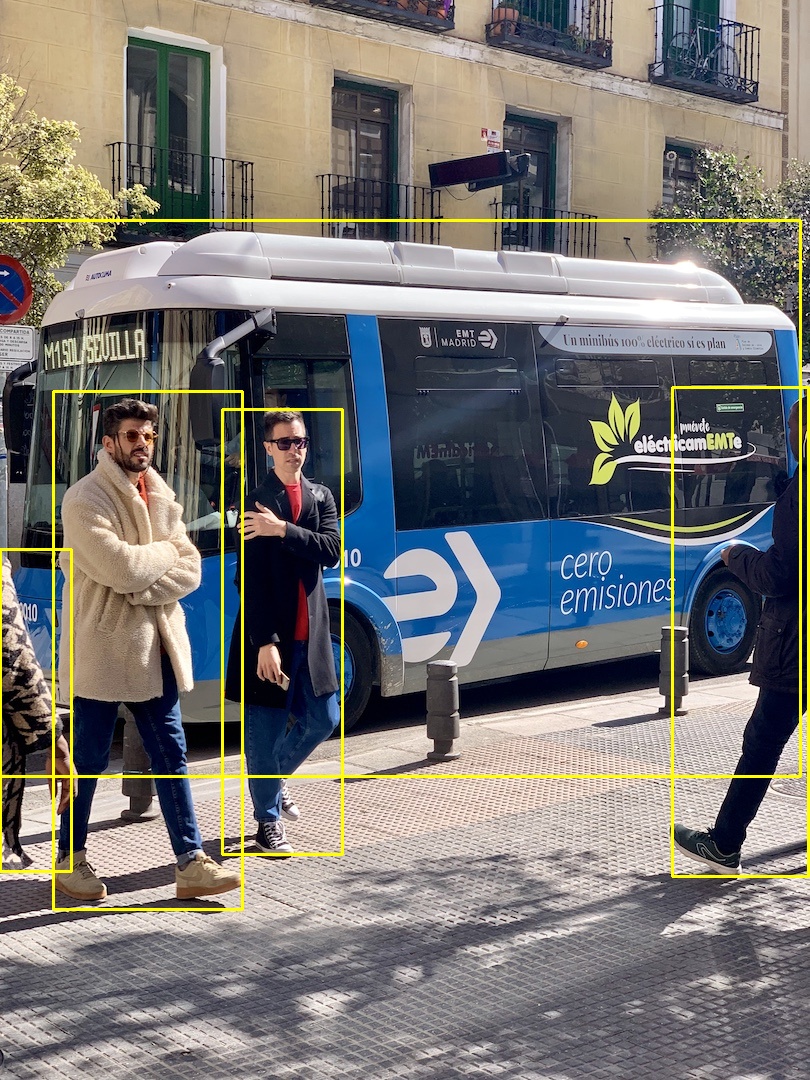

Doc/Images/YOLOV5_02.jpg

0 → 100644

479 KB

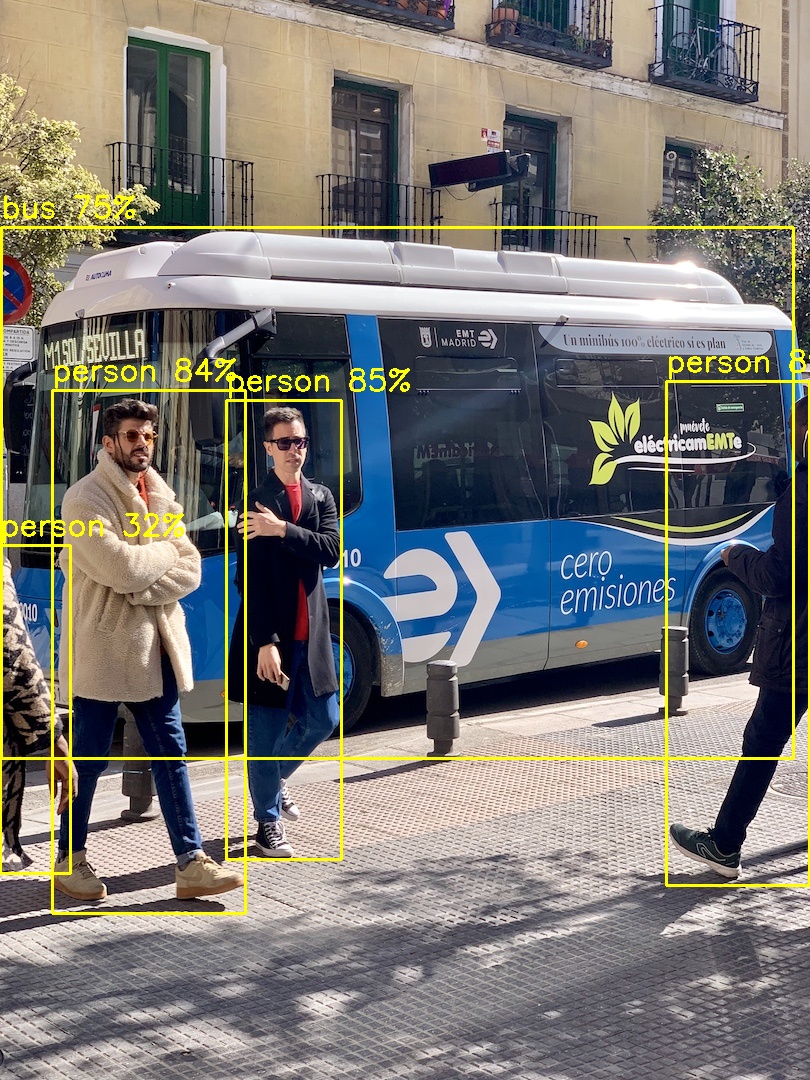

Doc/Images/YOLOV5_03.jpg

0 → 100644

487 KB

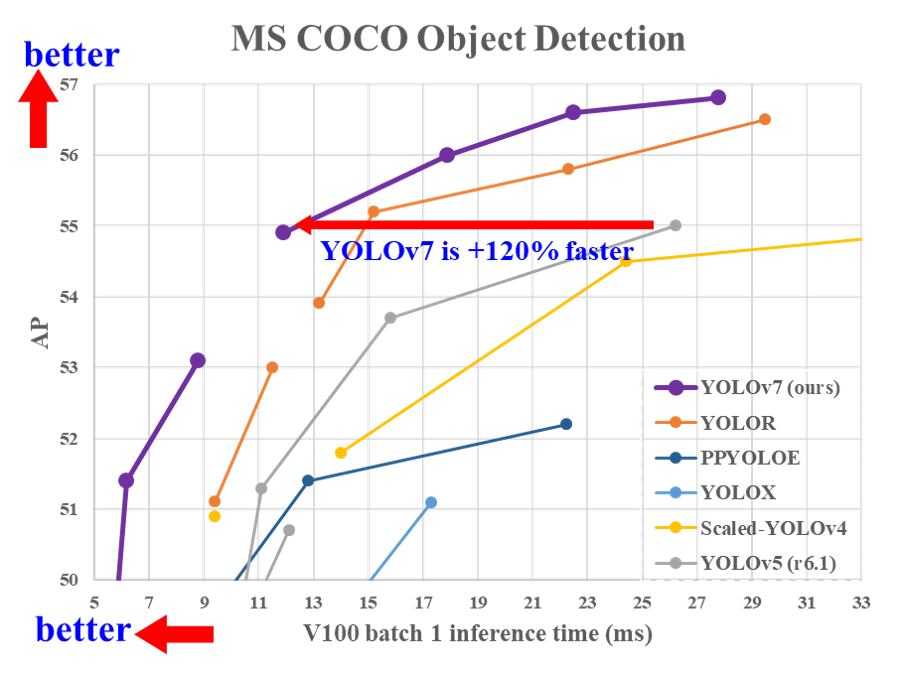

Doc/Images/YOLOV7_01.jpg

0 → 100644

489 KB

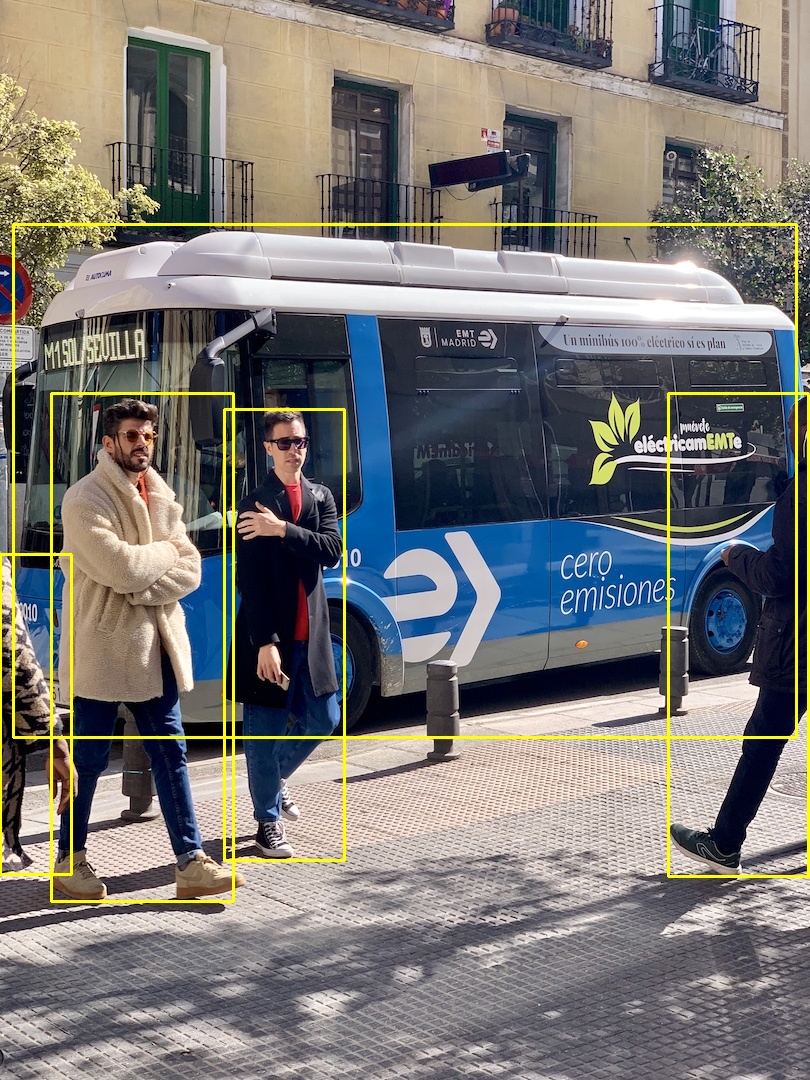

Doc/Images/YOLOV7_02.png

0 → 100644

165 KB

Doc/Images/YOLOV7_03.jpg

0 → 100644

479 KB

Doc/Tutorial.md

0 → 100644

This diff is collapsed.

Doc/Tutorial_Cpp/SSD.md

0 → 100644

Doc/Tutorial_Cpp/Unet.md

0 → 100644

Doc/Tutorial_Cpp/YOLOV3.md

0 → 100644