"StyleTextRec/configs/dataset_config.yml" did not exist on "b1623d69a57e2277545bf1cf511ec82458bbd106"

Merge pull request #2 from PaddlePaddle/develop

mergepaddleocr

Showing

Too many changes to show.

To preserve performance only 363 of 363+ files are displayed.

doc/datasets/ch_doc2.jpg

0 → 100644

2.42 KB

doc/datasets/ch_doc3.jpg

0 → 100644

2.07 KB

100 KB

114 KB

doc/datasets/cmb_demo.jpg

0 → 100644

90 KB

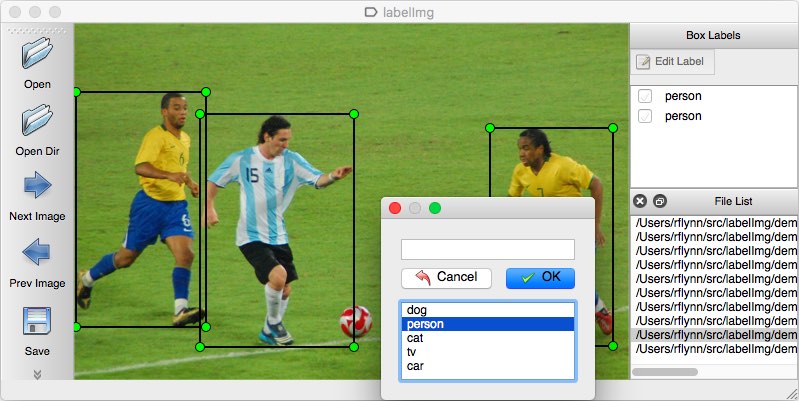

doc/datasets/labelimg.jpg

0 → 100644

89.1 KB

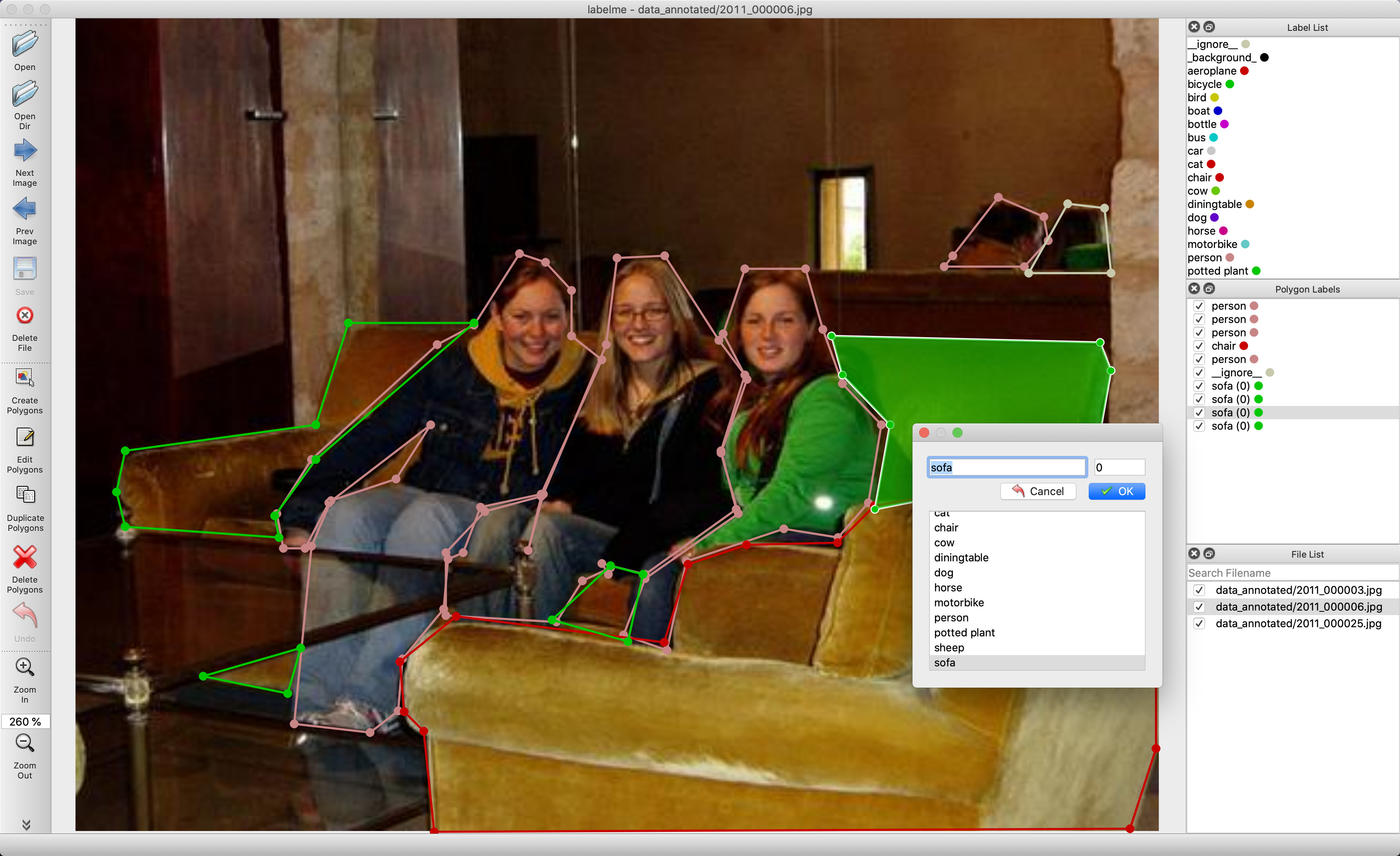

doc/datasets/labelme.jpg

0 → 100644

953 KB

doc/datasets/nist_demo.png

0 → 100644

4.12 KB

doc/datasets/rctw.jpg

0 → 100644

93.1 KB

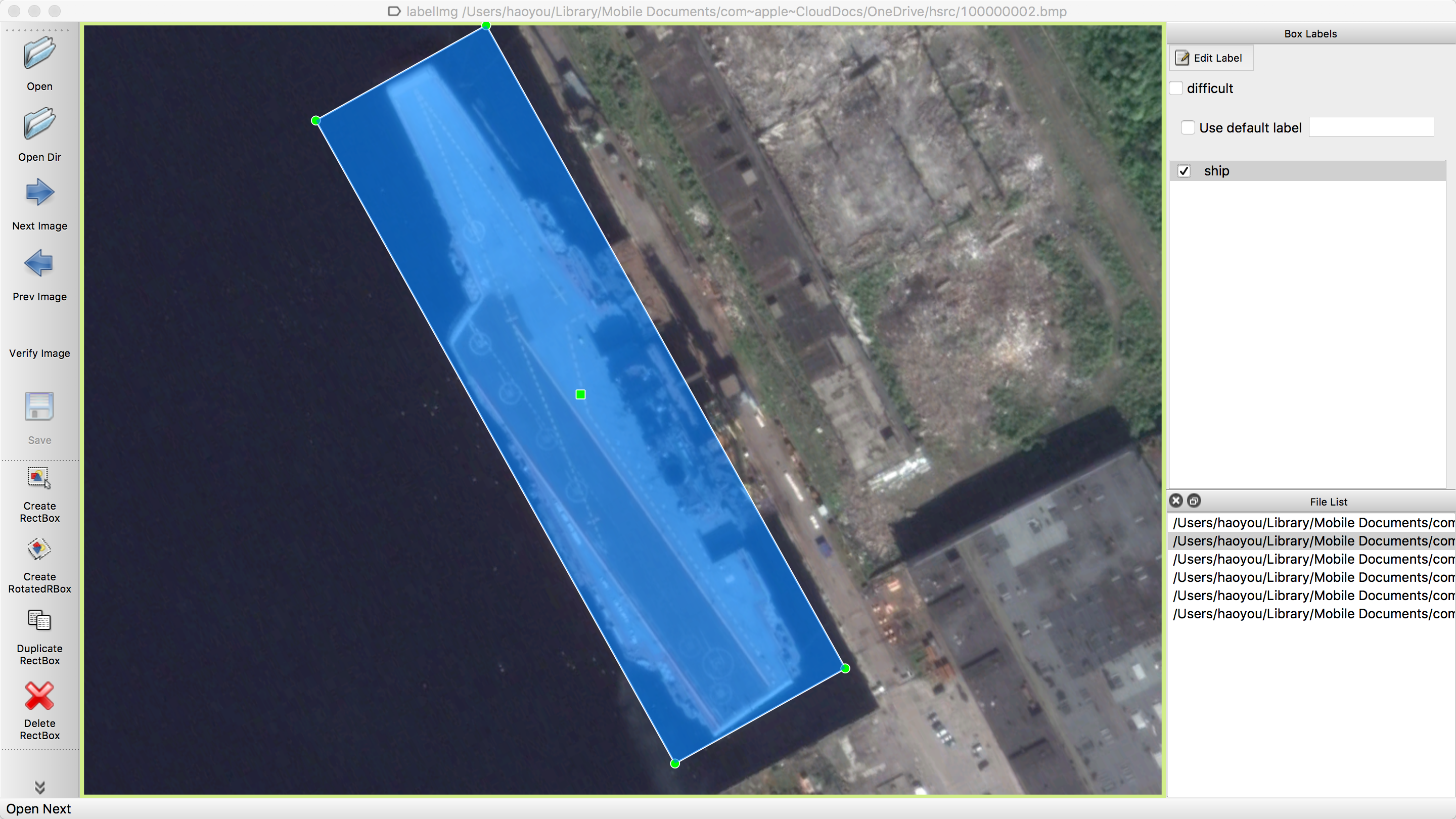

doc/datasets/roLabelImg.png

0 → 100644

3.78 MB

doc/demo/build.png

0 → 100644

13.1 KB

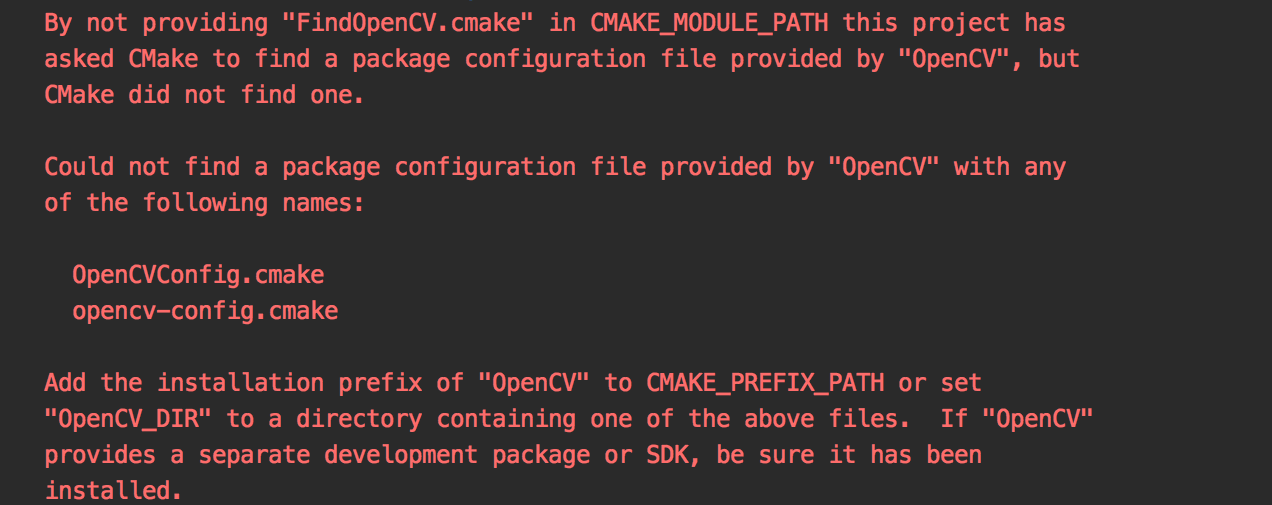

doc/demo/error.png

0 → 100644

105 KB

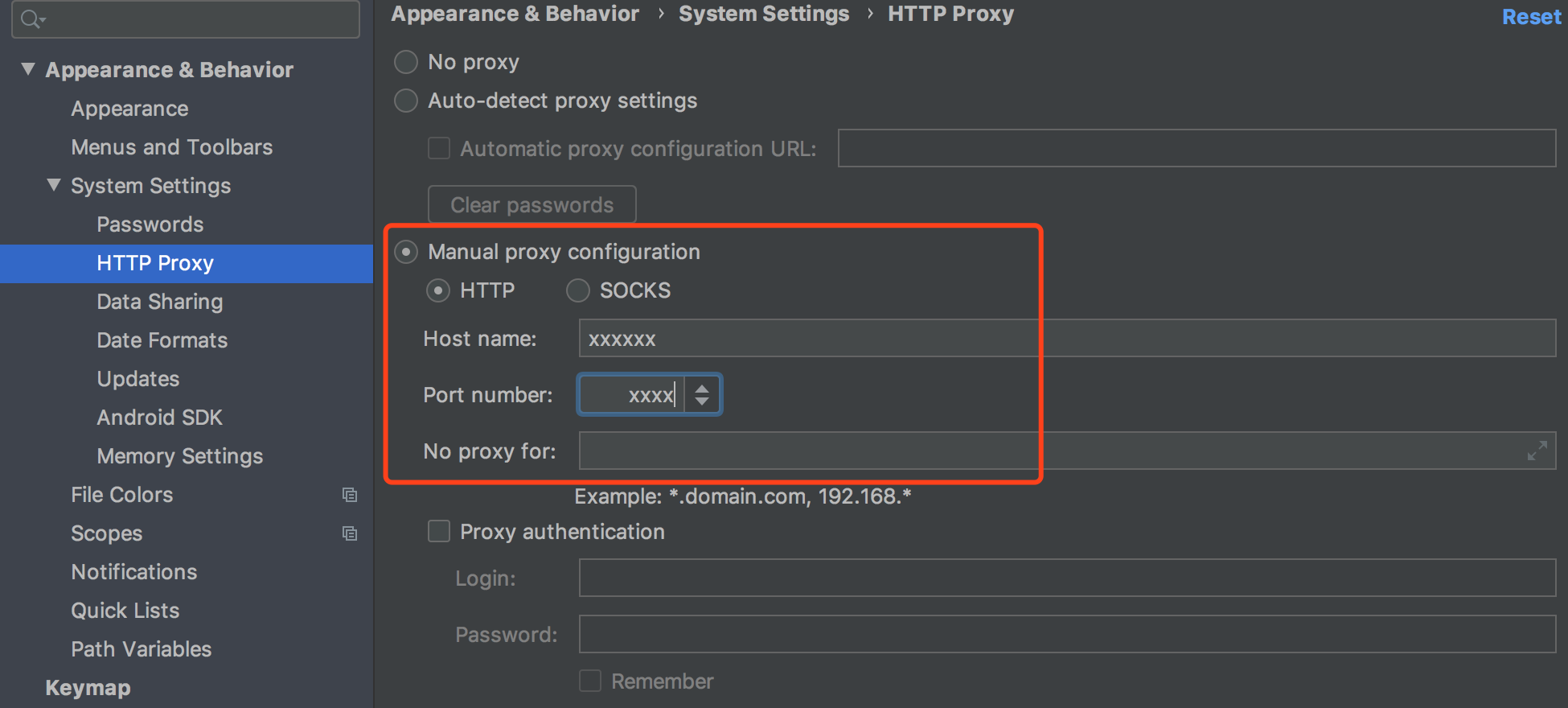

doc/demo/proxy.png

0 → 100644

185 KB

doc/doc_ch/FAQ.md

0 → 100644

doc/doc_ch/android_demo.md

0 → 100644

doc/doc_ch/benchmark.md

0 → 100644

doc/doc_ch/config.md

0 → 100644

doc/doc_ch/customize.md

0 → 100644

doc/doc_ch/data_synthesis.md

0 → 100644