Merge remote-tracking branch 'origin/dygraph' into dygraph

Showing

File moved

File moved

File moved

test_tipc/docs/install.md

0 → 100644

290 KB

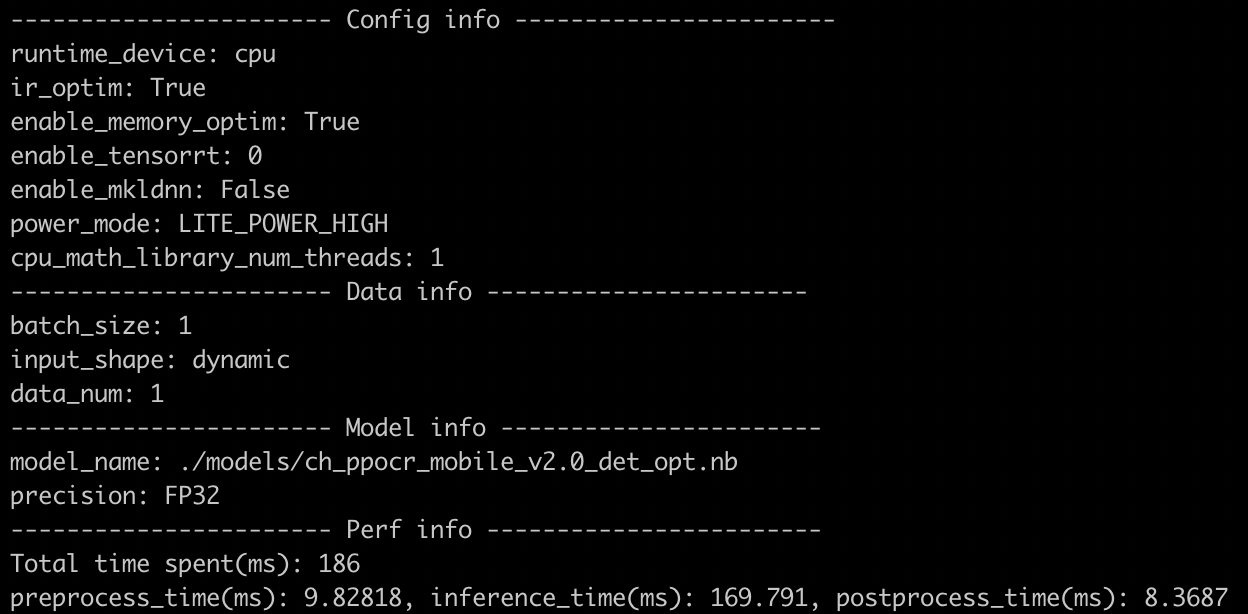

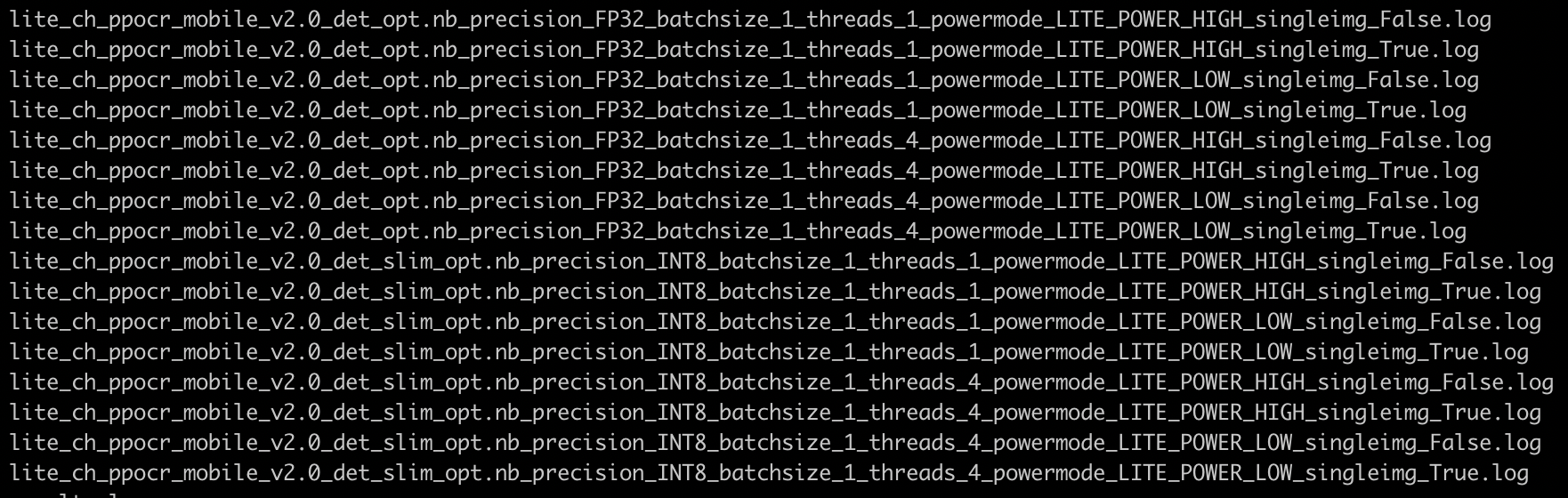

test_tipc/docs/lite_log.png

0 → 100644

776 KB

31.6 KB

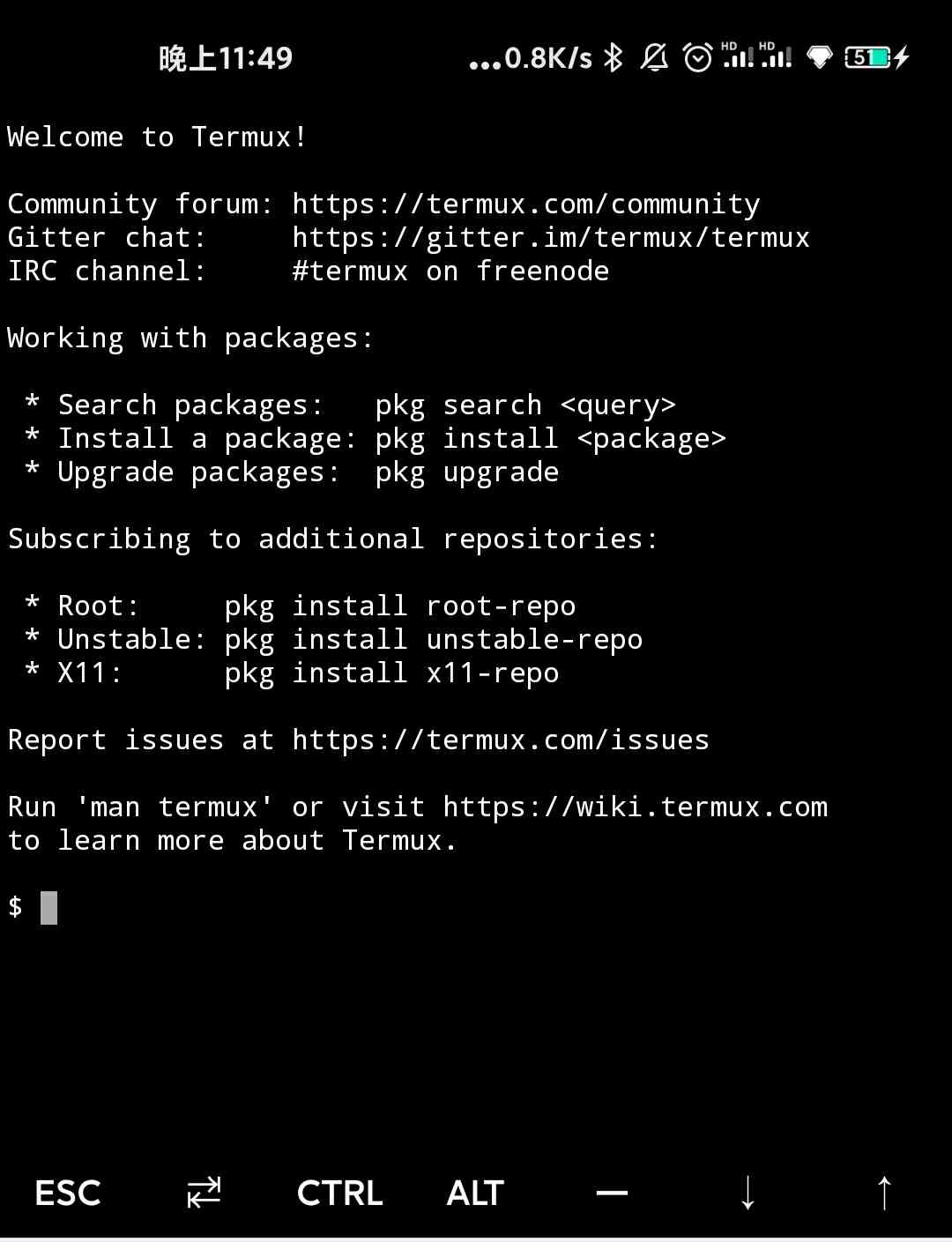

test_tipc/docs/termux.jpg

0 → 100644

74.1 KB

test_tipc/docs/test_lite.md

0 → 100644

File moved