update code

Showing

Too many changes to show.

To preserve performance only 323 of 323+ files are displayed.

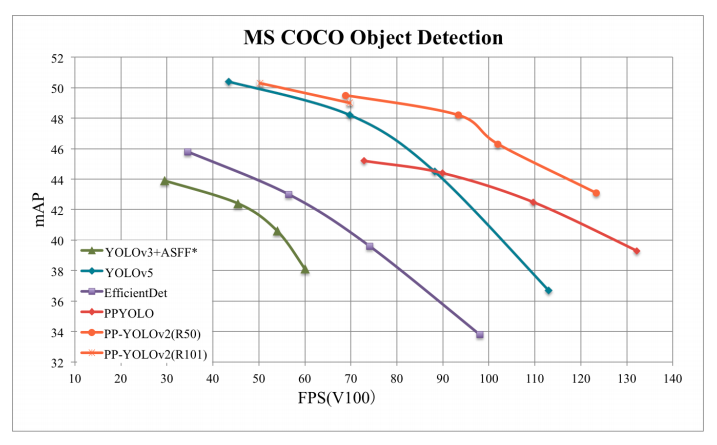

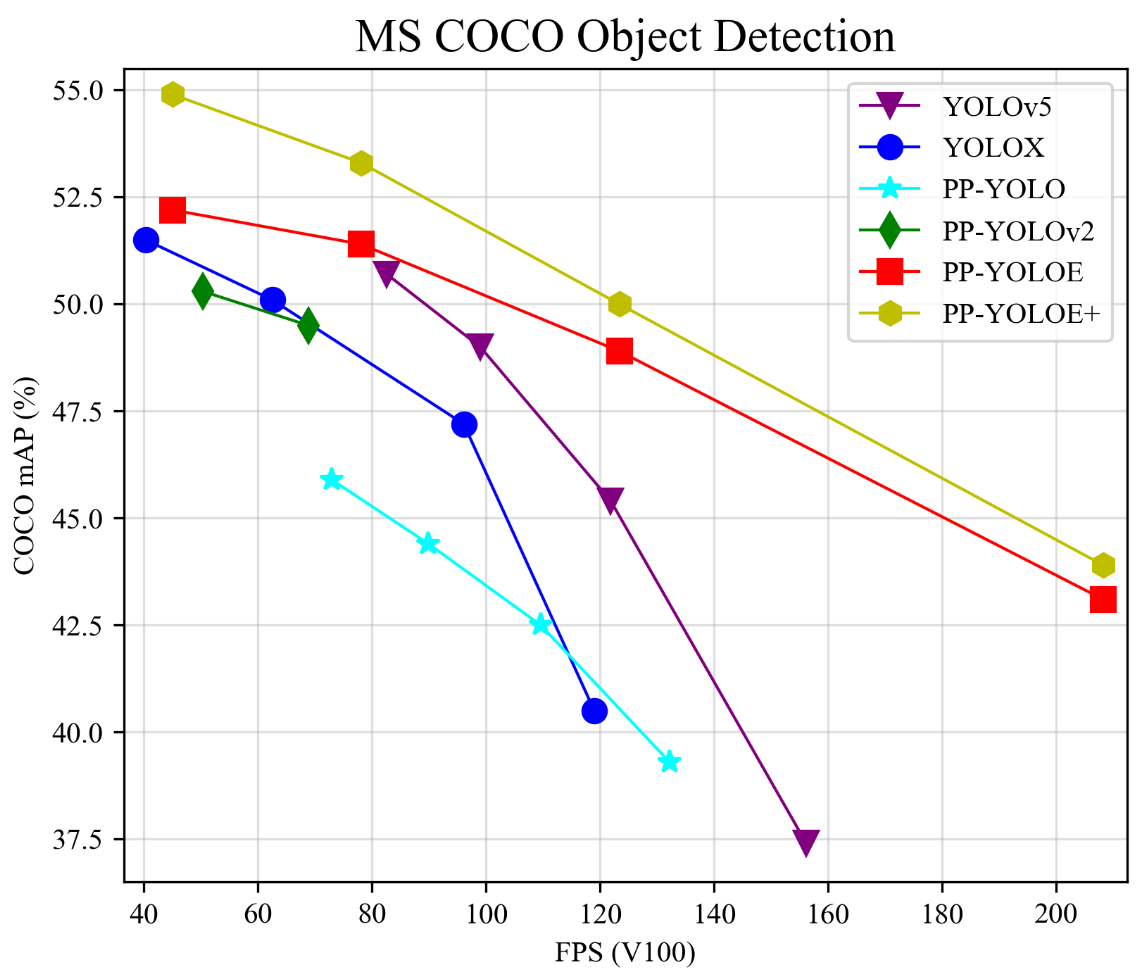

docs/images/fps_map.png

0 → 100644

338 KB

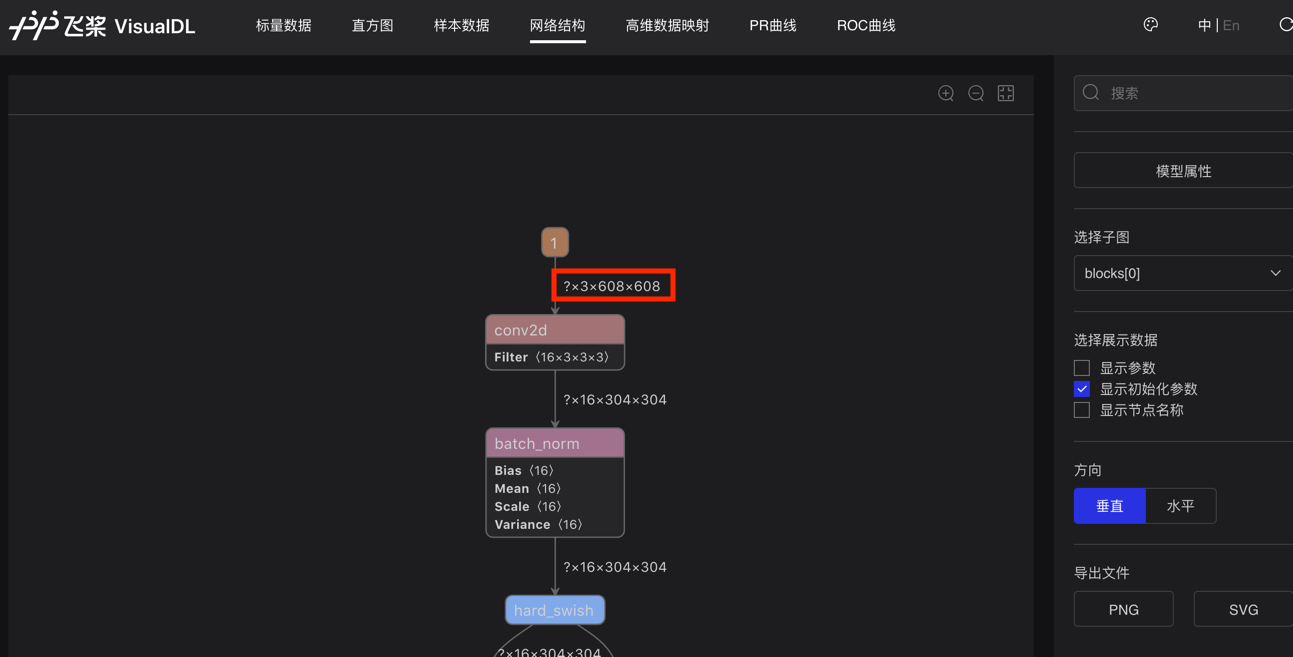

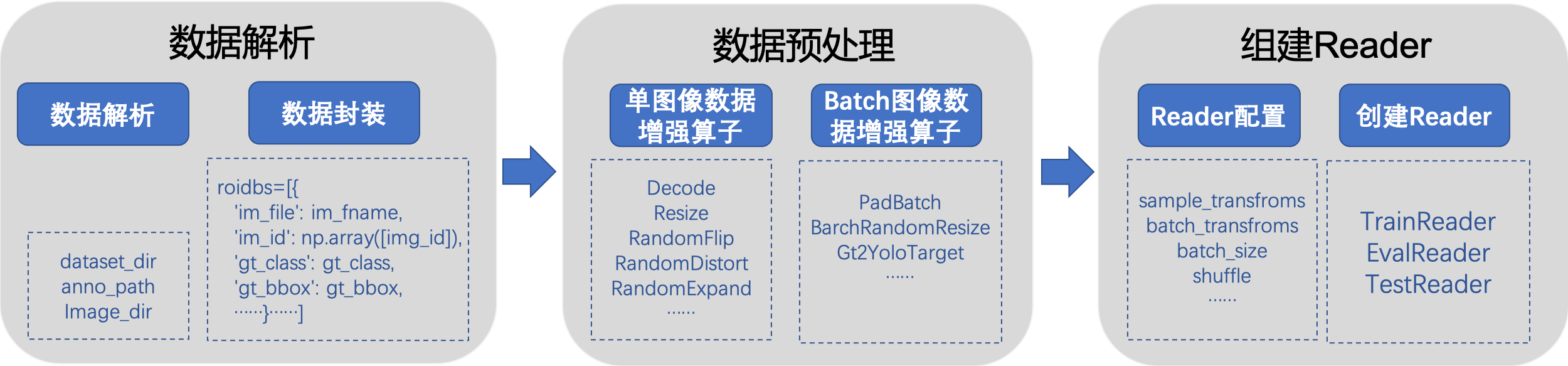

docs/images/input_shape.png

0 → 100644

105 KB

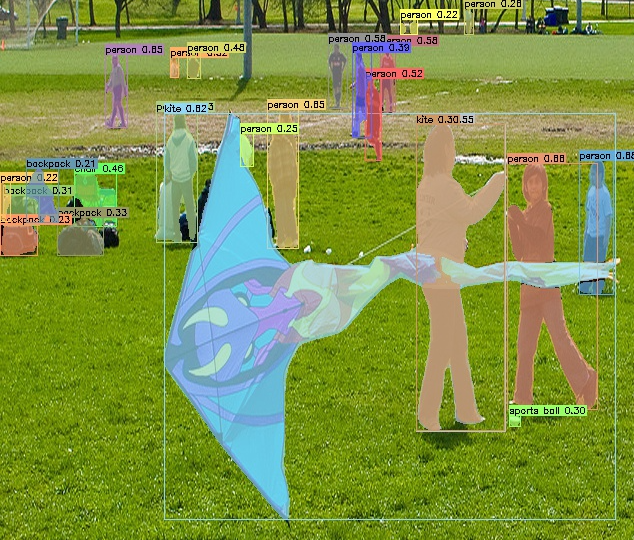

docs/images/instance_seg.png

0 → 100644

820 KB

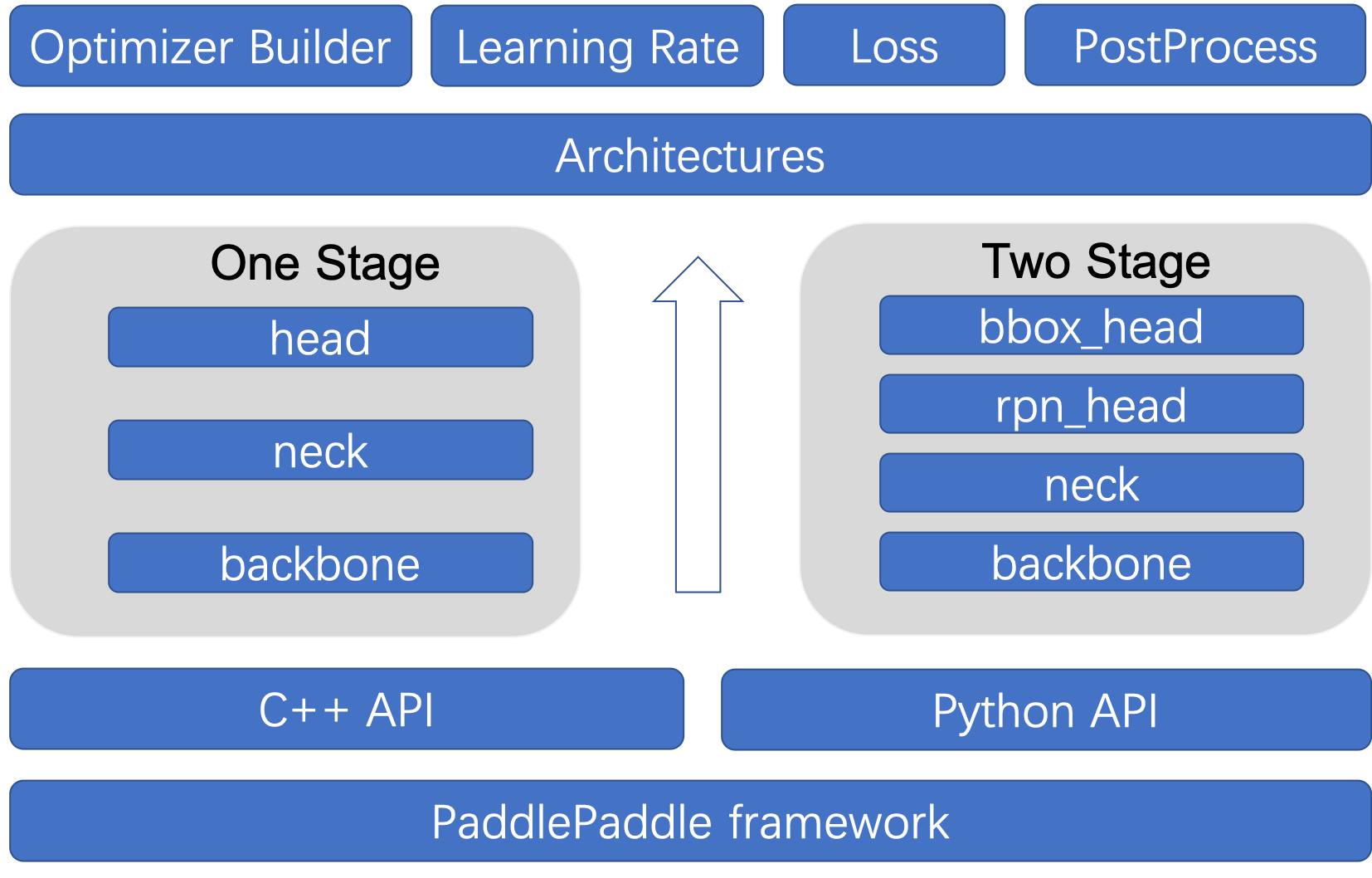

docs/images/layout.jpg

0 → 100644

346 KB

docs/images/lite_demo.jpg

0 → 100644

939 KB

312 KB

docs/images/model_figure.png

0 → 100644

148 KB

428 KB

docs/images/ppdet.gif

0 → 100644

This image diff could not be displayed because it is too large. You can view the blob instead.

121 KB

179 KB

195 KB

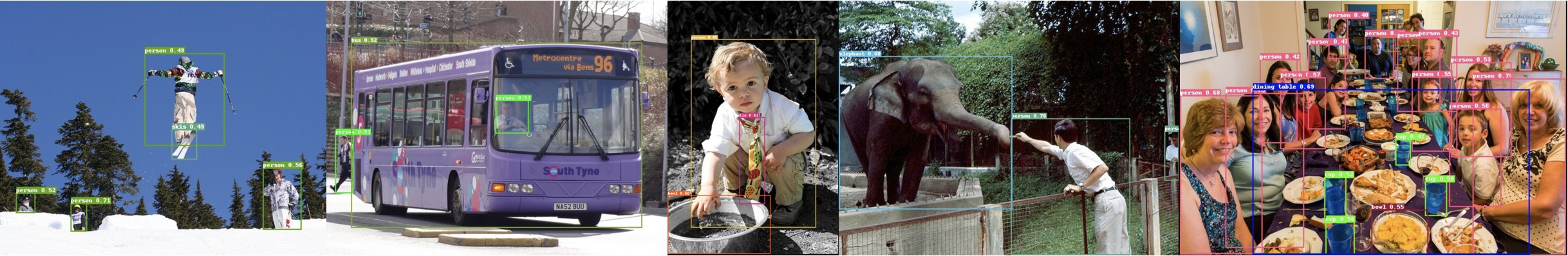

docs/images/res.jpg

0 → 100644

481 KB

docs/images/road554.png

0 → 100644

142 KB

docs/images/roadsign_yml.png

0 → 100644

102 KB

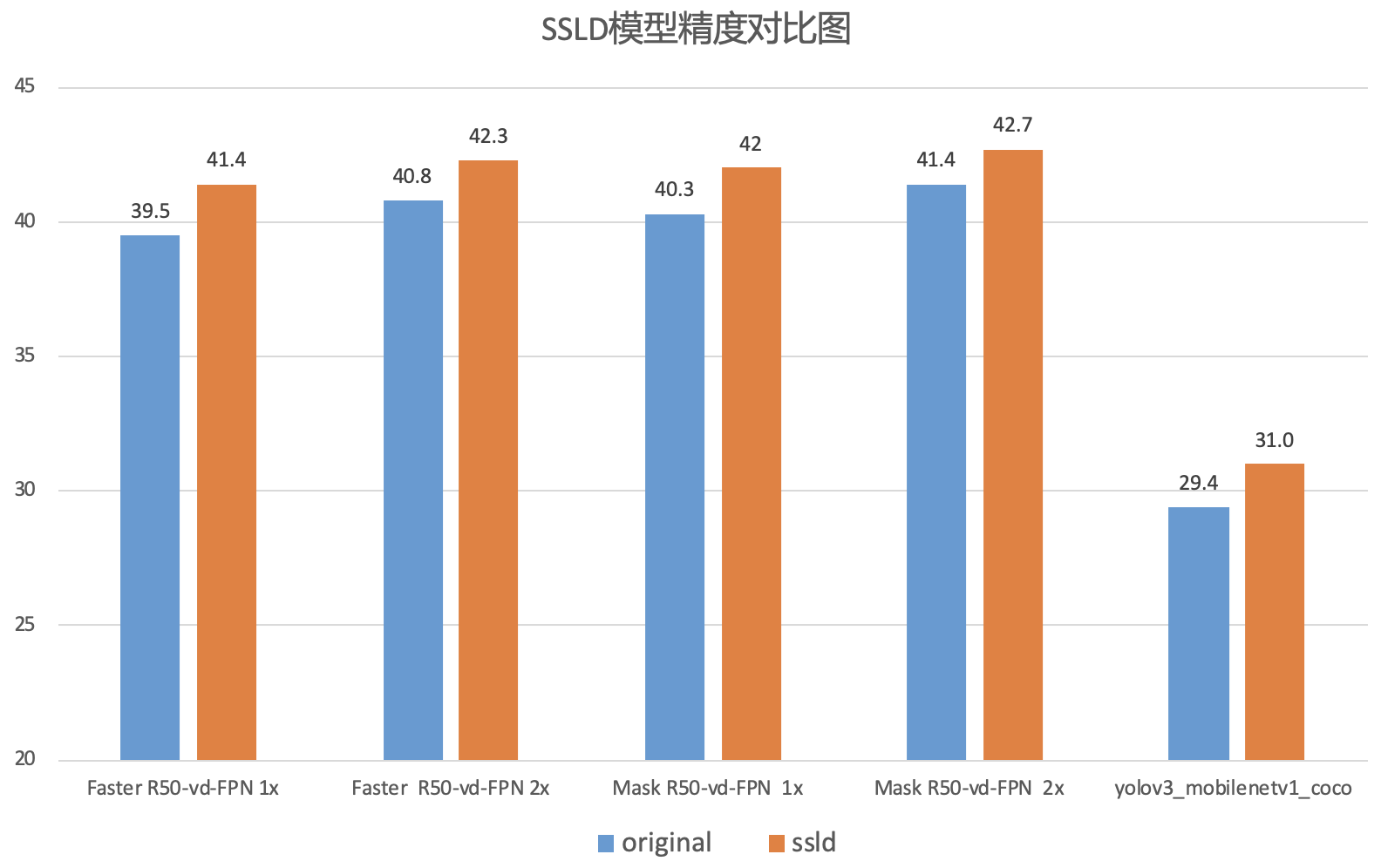

docs/images/ssld_model.png

0 → 100644

79.7 KB

docs/images/yaml_show.png

0 → 100644

668 KB

docs/tutorials/FAQ/FAQ第一期.md

0 → 100644