提交yi推理

parents

Showing

.gitmodules

0 → 100644

README.md

0 → 100644

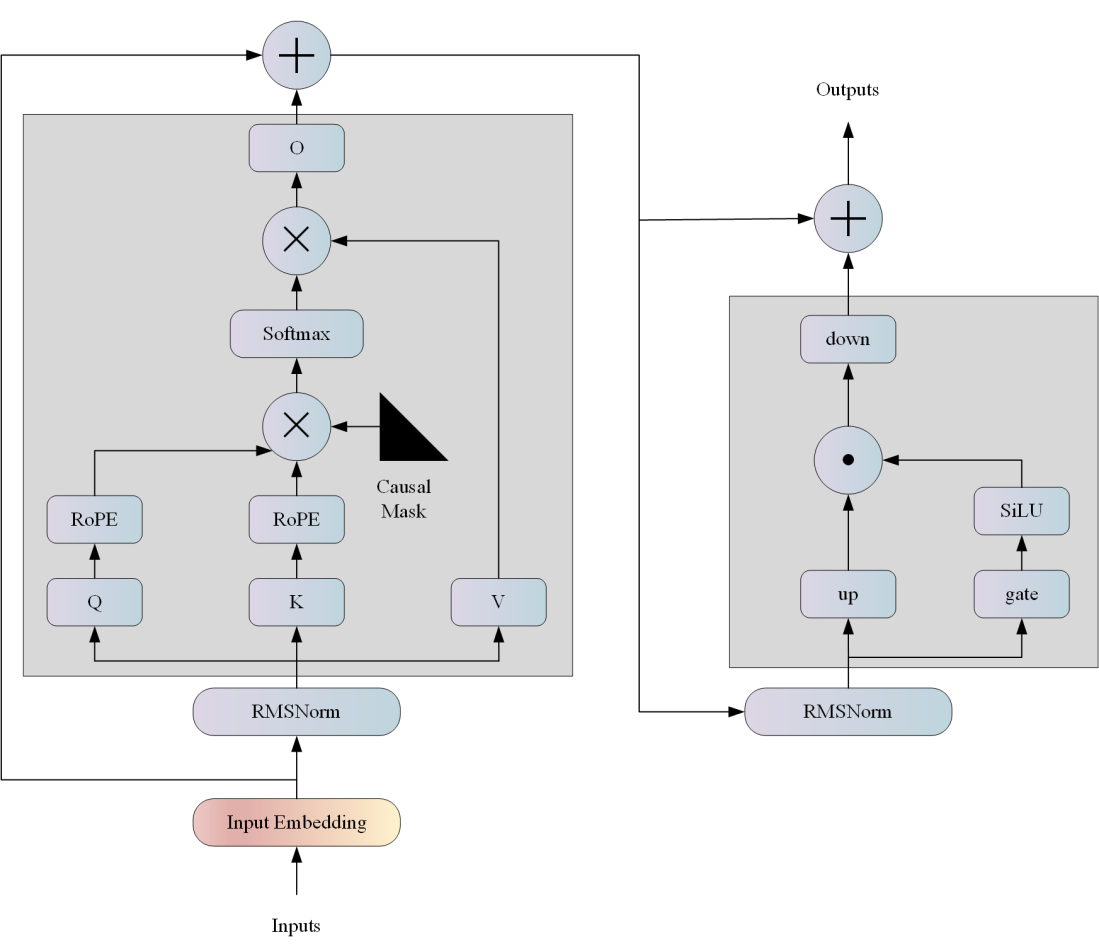

docs/llama.png

0 → 100644

77.3 KB

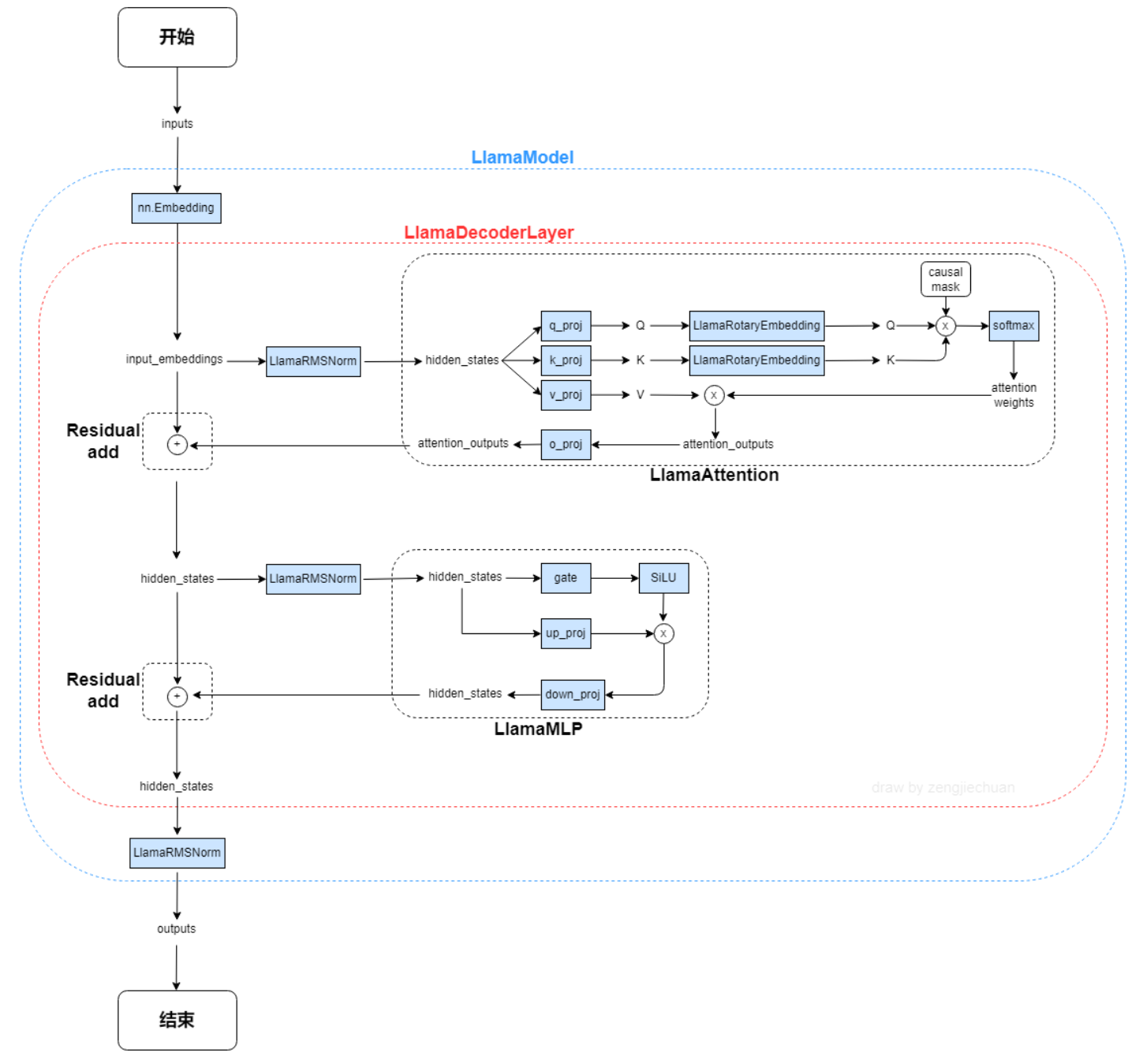

docs/llama_1.png

0 → 100644

188 KB

model.properties

0 → 100644