modify readme

Showing

docker/Dockerfile

0 → 100644

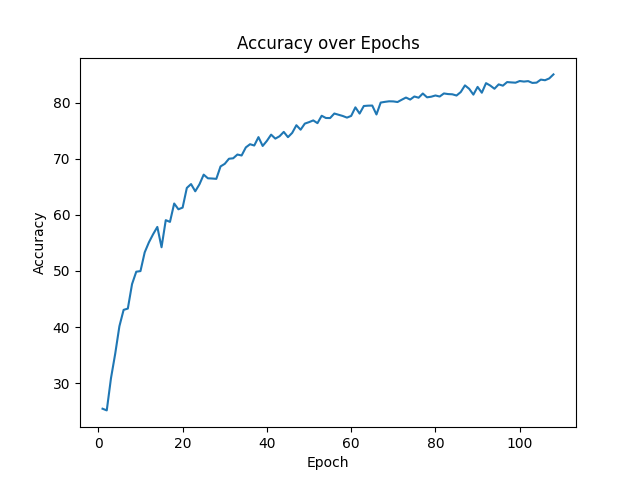

img/accuracy.png

0 → 100644

24.1 KB

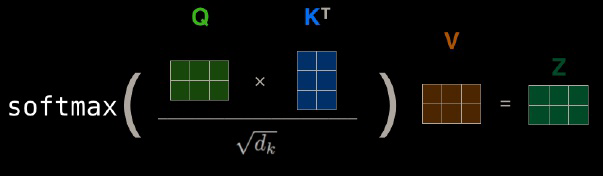

img/attention.png

0 → 100644

28.4 KB

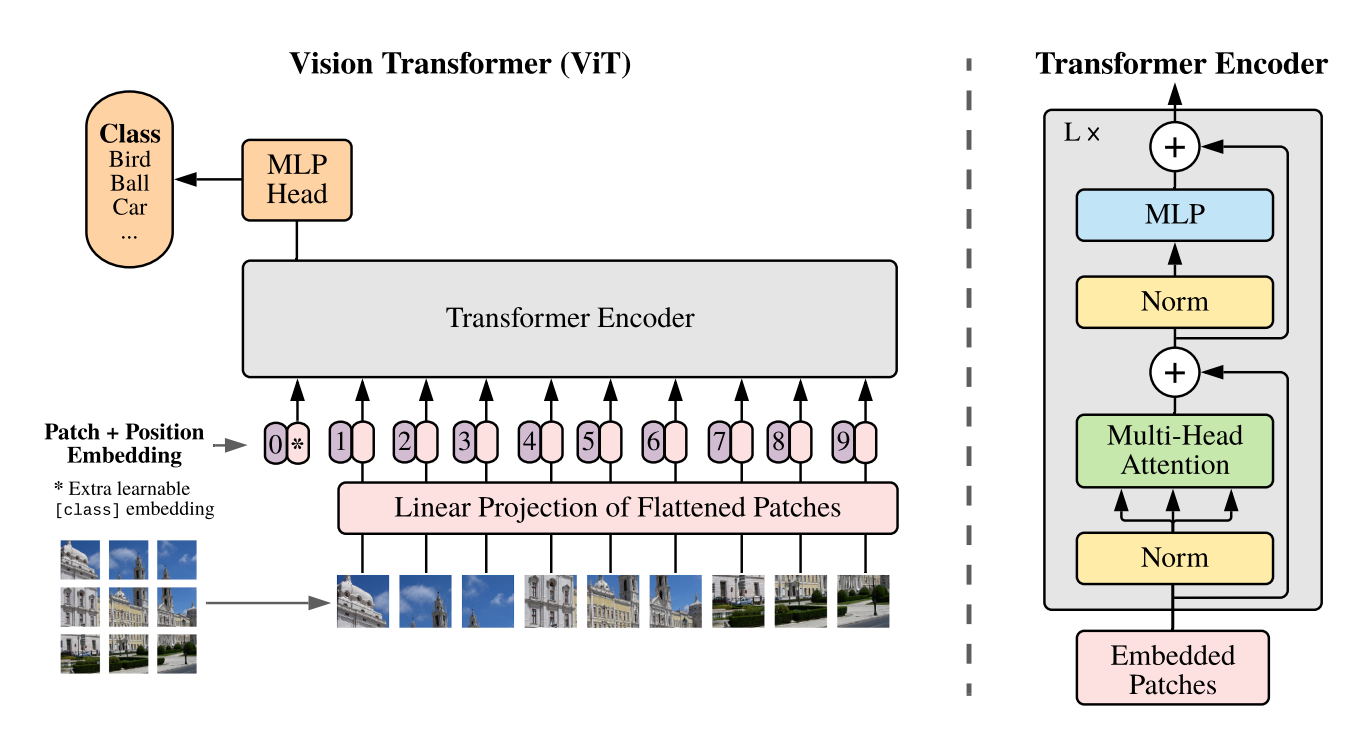

img/vit.png

0 → 100644

223 KB

24.1 KB

28.4 KB

223 KB