Update

Signed-off-by:  lijian <lijian6@sugon.com>

lijian <lijian6@sugon.com>

Showing

Doc/Tutorial_Cpp/YOLOV3.md

0 → 100644

Doc/Tutorial_Cpp/YOLOV5.md

0 → 100644

Doc/Tutorial_Cpp/YOLOV7.md

0 → 100644

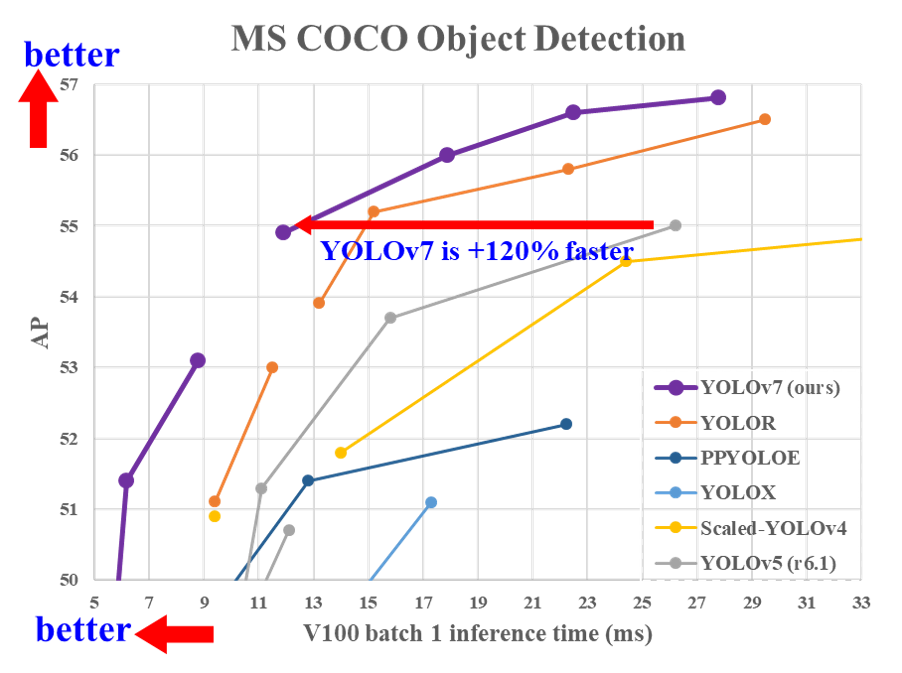

Doc/YOLOV7_01.png

0 → 100644

165 KB

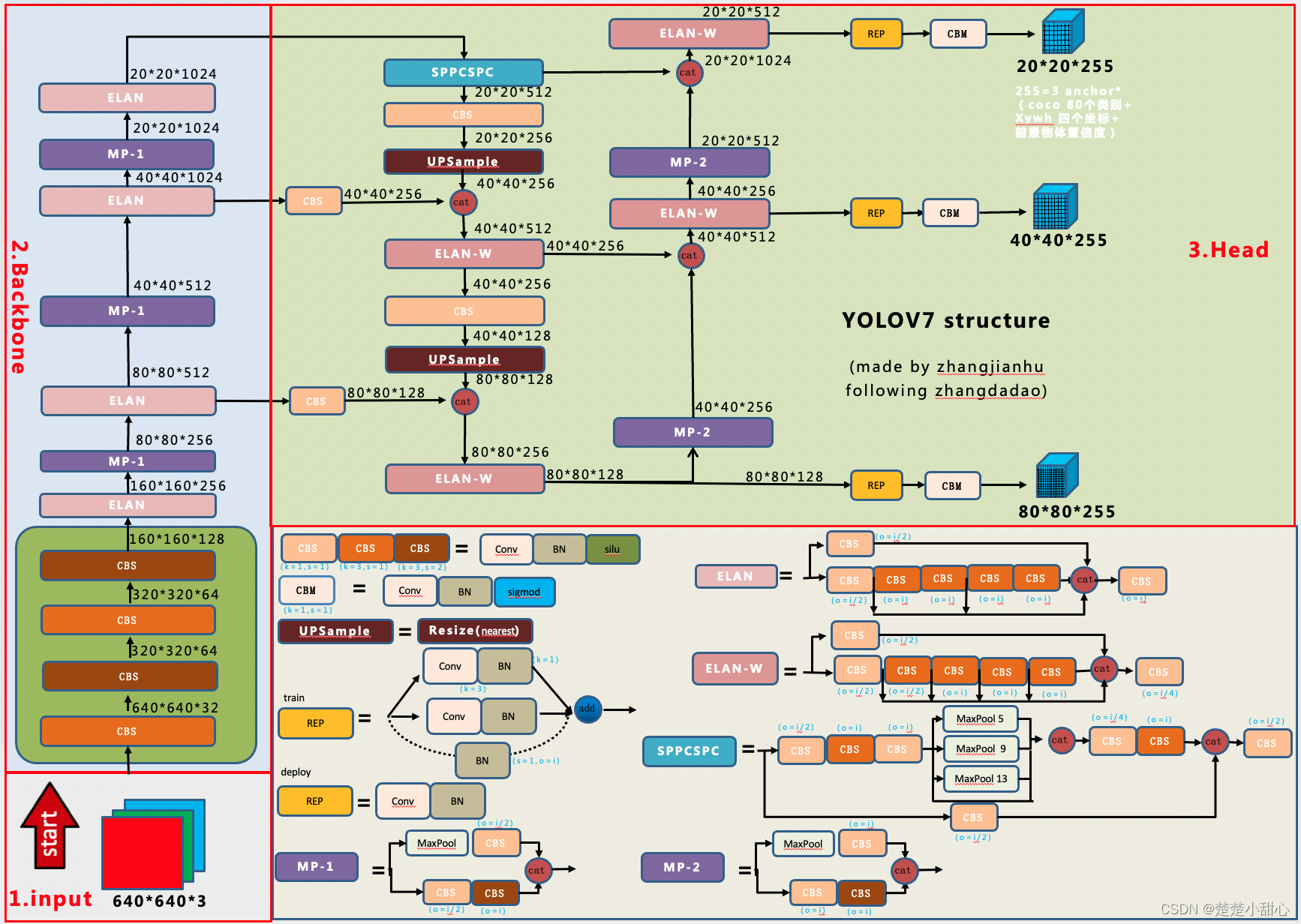

Doc/YoloV7_model.png

0 → 100644

2.17 MB

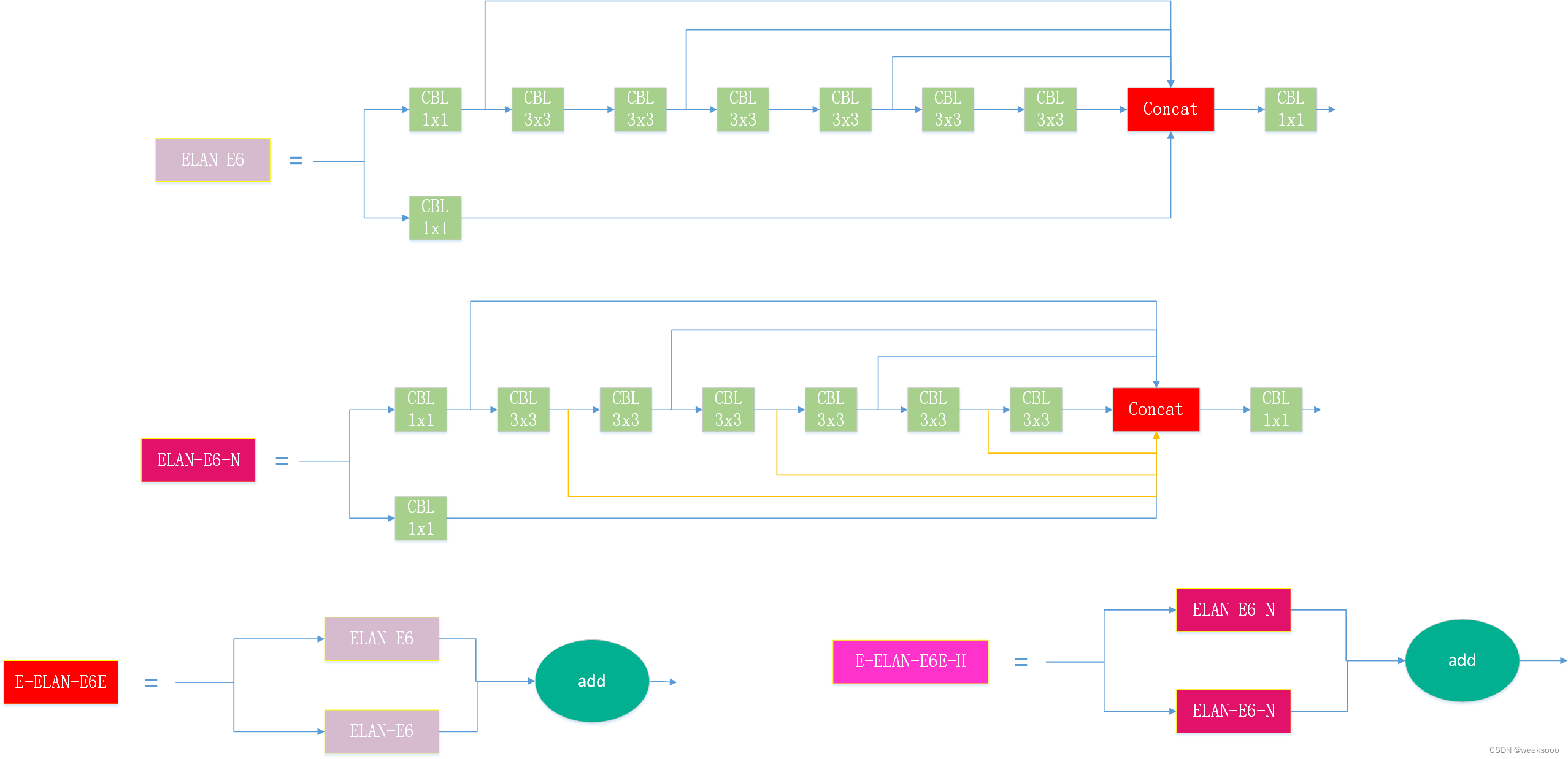

Doc/YoloV7_suanfa.png

0 → 100644

90.6 KB

Doc/image.gif

0 → 100644

7.66 MB

docker/Dockerfile

0 → 100644