"tests/experimental/__init__.py" did not exist on "44b9bcd811cb7f38980a265f53342bee2b602507"

Merge branch 'zhanggezhong-main-patch-10329' into 'main'

Update README.md See merge request !4

Showing

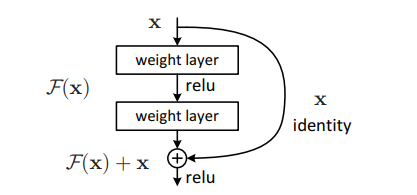

image-1.png

0 → 100644

15.2 KB

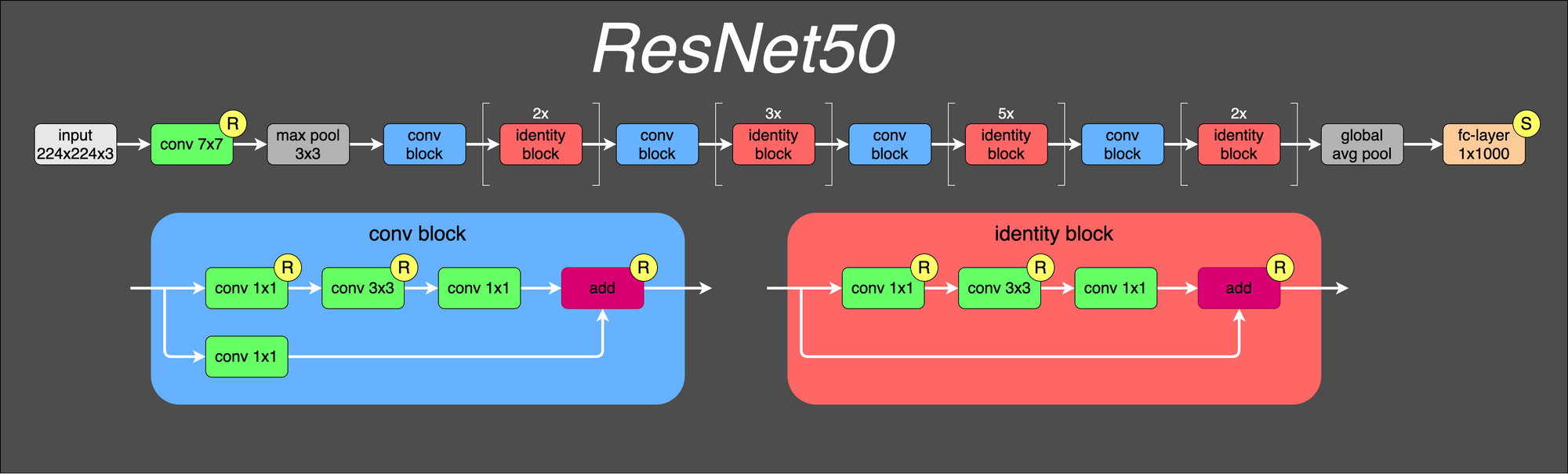

image.png

0 → 100644

210 KB

kitten-1.jpg

0 → 100644

108 KB