Update

Signed-off-by:  lijian <lijian6@sugon.com>

lijian <lijian6@sugon.com>

Showing

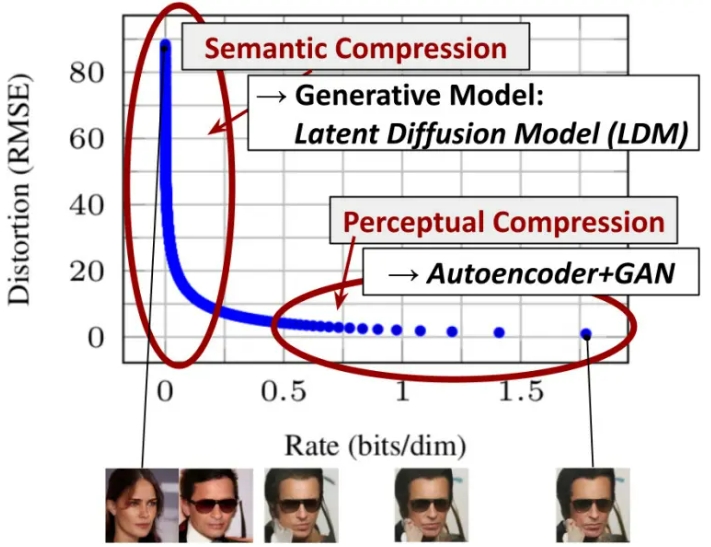

doc/algo.png

0 → 100644

165 KB

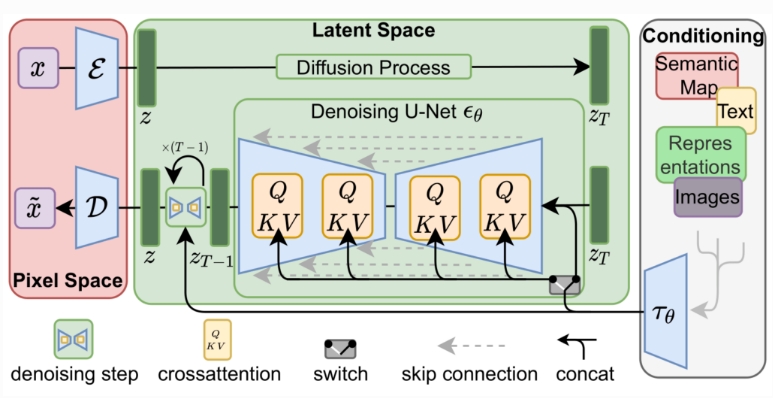

doc/arch.png

0 → 100644

136 KB

doc/result.png

0 → 100644

2.81 MB

docker/Dockerfile

0 → 100644