添加数据文件

Showing

docs/qwen.png

0 → 100644

112 KB

docs/qwen推理.gif

0 → 100644

This image diff could not be displayed because it is too large. You can view the blob instead.

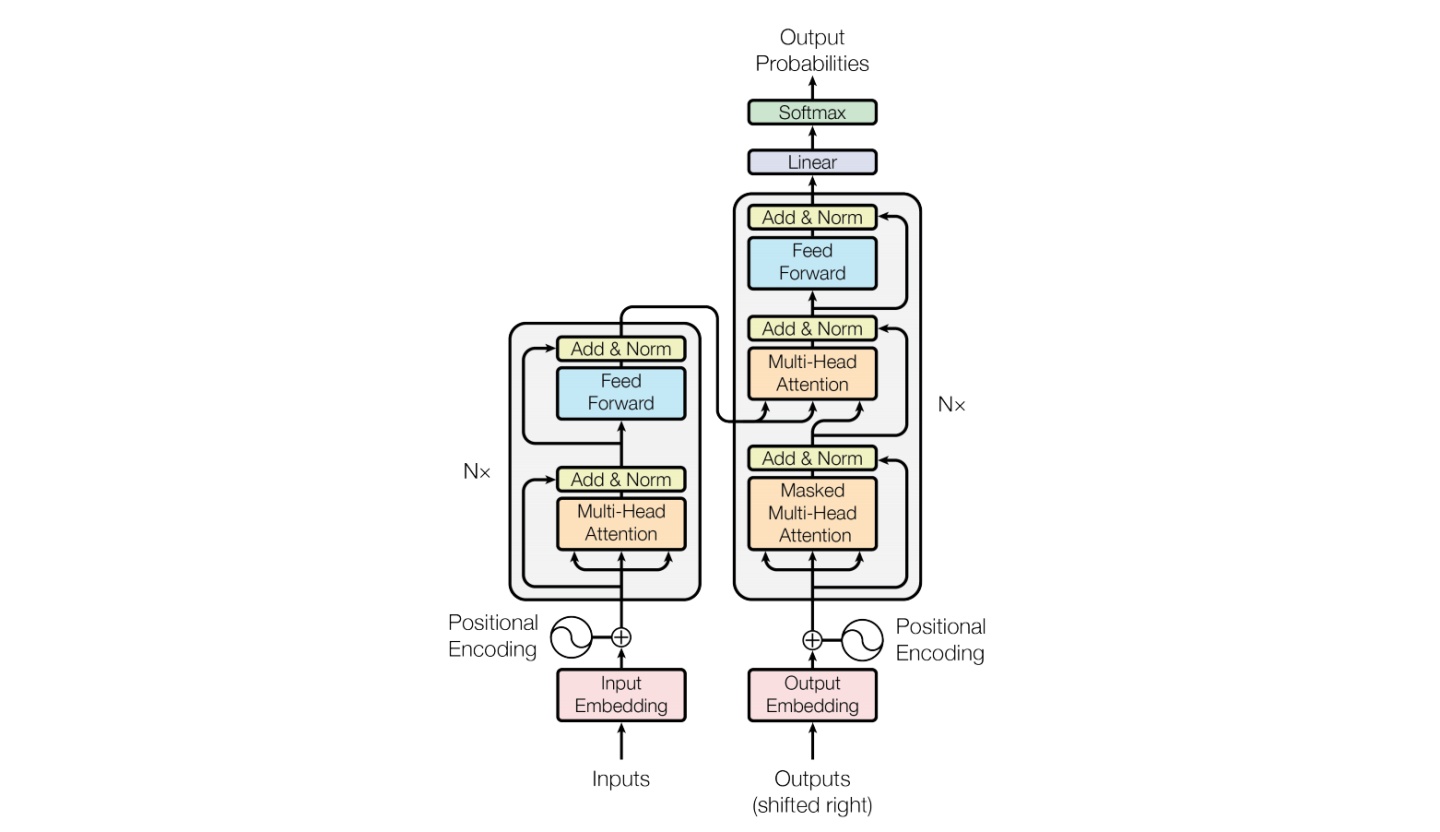

docs/transformer.jpg

0 → 100644

87.9 KB

model.properties

0 → 100644