[性能]Qwen3-Next-80B-A3B-Thinking在通过docker-compose命令启动时比在容器内手动执行时显著降低了代吞吐量

1. 问题描述 在同一台机器、同一镜像、同一模型权重、同一启动脚本的情况下, 仅启动方式不同(docker-compose 自动启动 vs 容器内手动启动), 模型推理性能存在明显差异。 docker-compose 自动启动模型时: gen throughput (token/s) ≈ 7 进入容器后手动执行同一个启动脚本: gen throughput (token/s) ≈ 16 差异接近 2×,可稳定复现。

2. 环境信息 Model: Qwen3-Next-80B-A3B-Thinking; Framework: sglang(基于 qwen3-next-sglang 官方手册); GPU: 海光 K100 AI × 4; OS: 统信 UOS1070a; Docker version: Docker version 20.10.7, build f0df350; Image: 0.9.2-ubuntu22.04-dtk25.04.1-rc5-rocblas101839-0811-das1.6-py3.10-20250908-rc1-next80b-only-fixed(手册镜像 + 下载安装sglang + 安装Python包 二次构建)

3. 启动方式对比

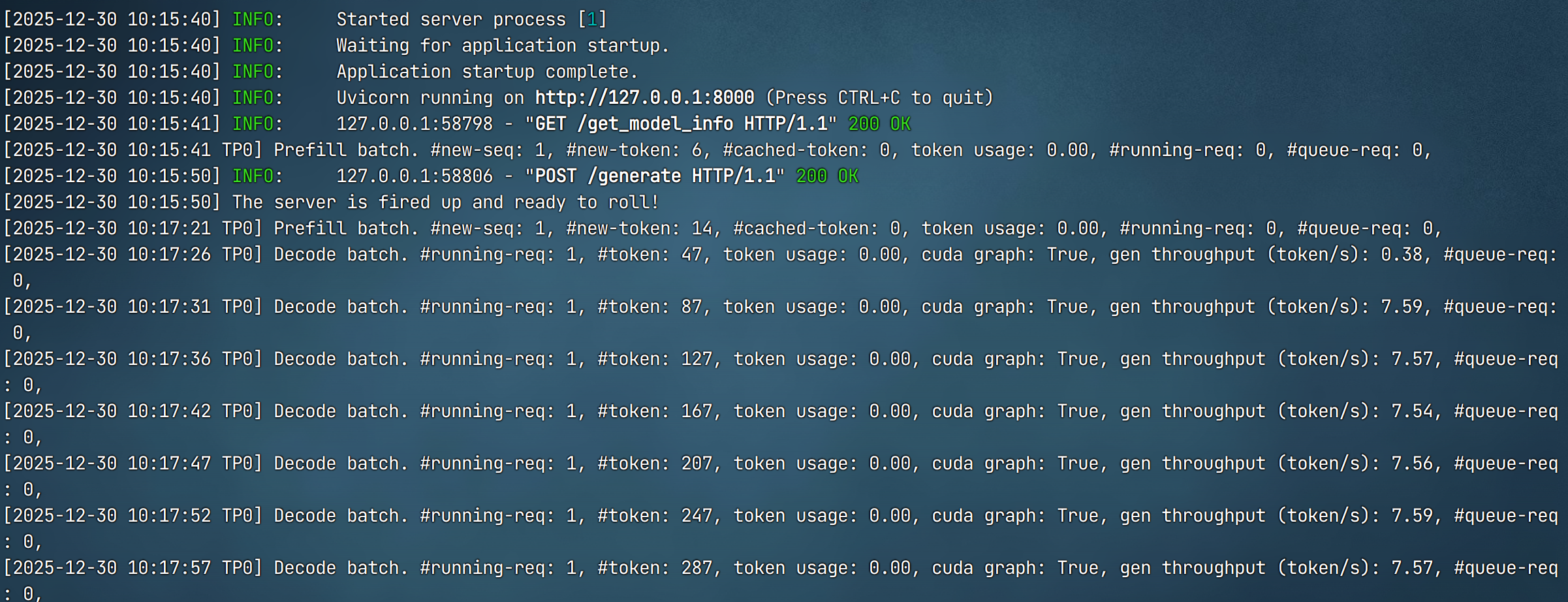

方式一:docker-compose 自动启动(性能较低)

qwen3-next.yml 中模型服务启动方式如下:

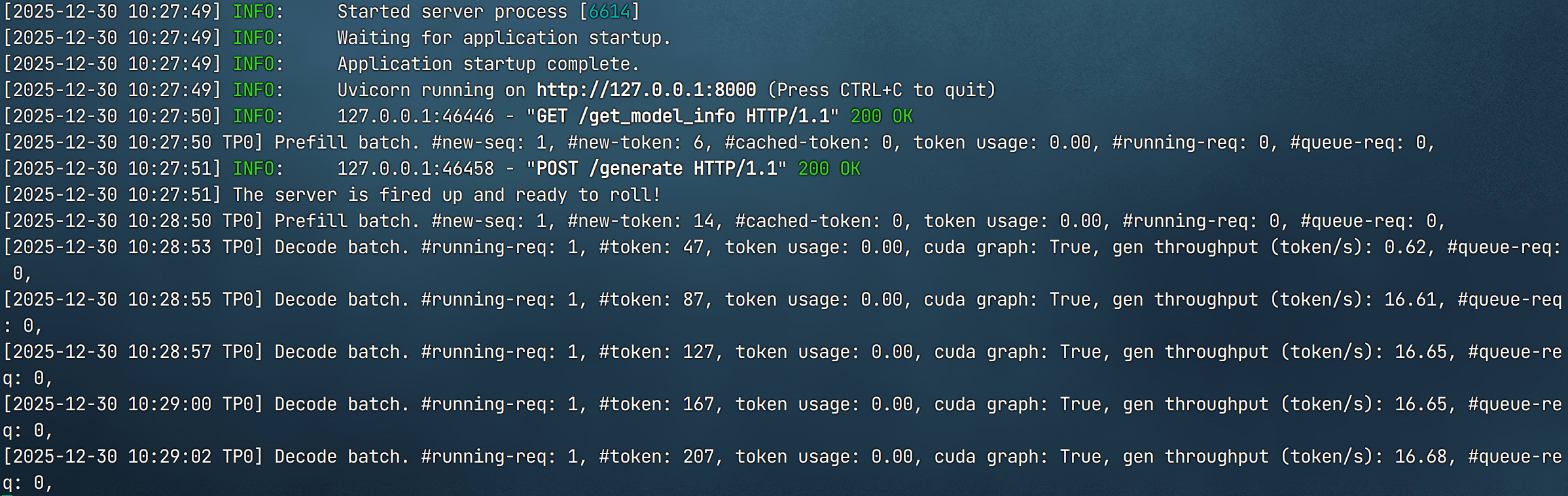

方式二:容器内手动启动(性能正常)

docker exec -it <container_id> bash,

sh /workspace/vLLm/qwen3-next.sh

相同测试请求下:

4. 其他说明 两种方式使用 完全相同的启动脚本 启动参数、模型权重路径、GPU 数量、请求方式均一致 问题在多次重启、重复测试中均可复现

5. 期望行为 docker-compose 自动启动与容器内手动启动在性能表现上应保持一致

6. 请求协助 希望社区协助确认:

- 是否为已知问题或设计预期行为

- 是否有推荐的 docker / compose 启动方式或参数

- 是否需要在 compose 中显式设置环境变量、entrypoint 或 runtime 参数