Skip to content

GitLab

Menu

Projects

Groups

Snippets

Loading...

Help

Help

Support

Community forum

Keyboard shortcuts

?

Submit feedback

Contribute to GitLab

Sign in / Register

Toggle navigation

Menu

Open sidebar

ModelZoo

JIUTIAN-139MoE-Chat

Commits

476d2f1e

Commit

476d2f1e

authored

Oct 12, 2024

by

ACzhangchao

Browse files

Update README

parent

0acb55cc

Changes

1

Hide whitespace changes

Inline

Side-by-side

Showing

1 changed file

with

2 additions

and

2 deletions

+2

-2

README.md

README.md

+2

-2

No files found.

README.md

View file @

476d2f1e

...

@@ -8,13 +8,13 @@ https://www.modelscope.cn/models/JiuTian-AI/JIUTIAN-139MoE-chat/file/view/master

...

@@ -8,13 +8,13 @@ https://www.modelscope.cn/models/JiuTian-AI/JIUTIAN-139MoE-chat/file/view/master

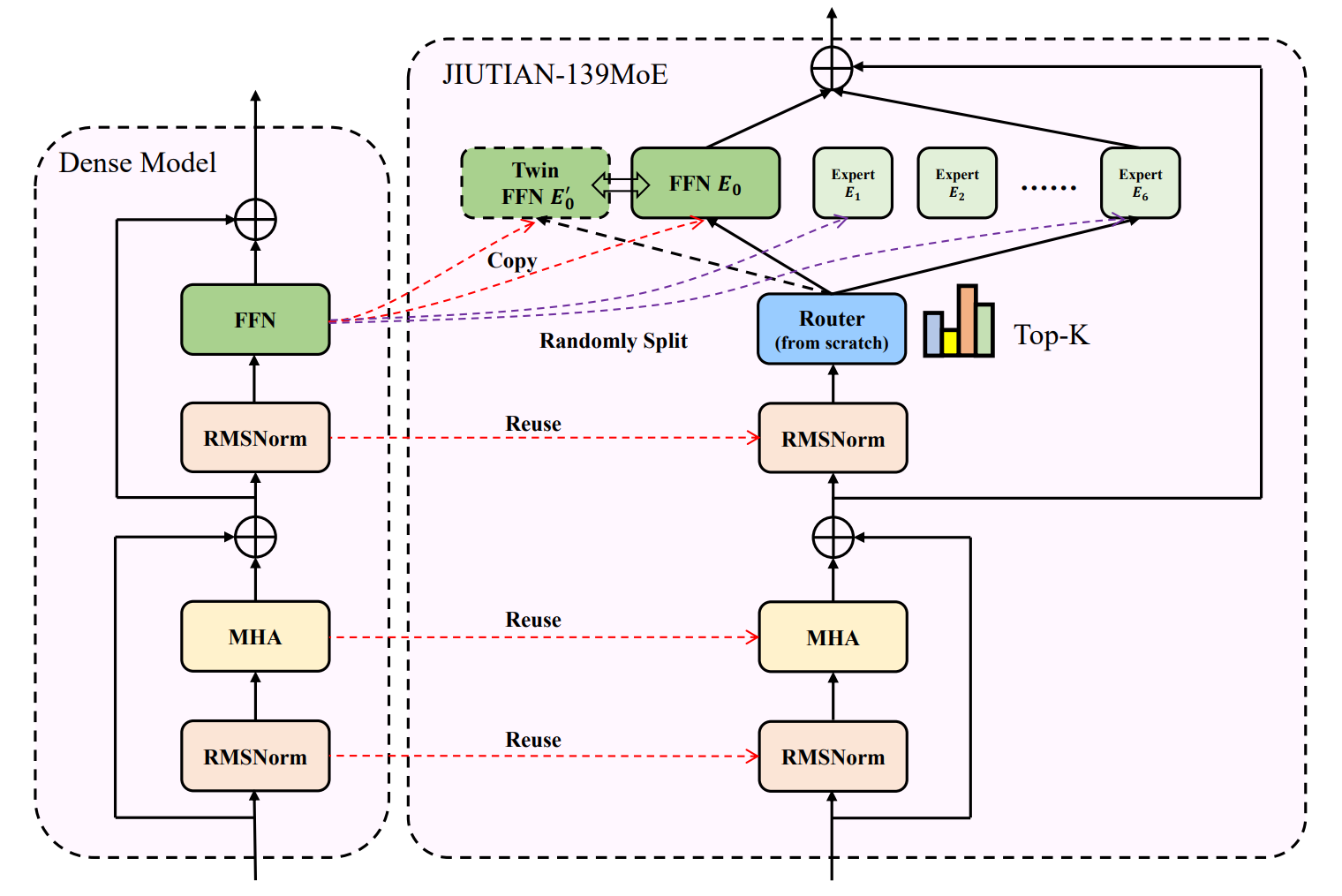

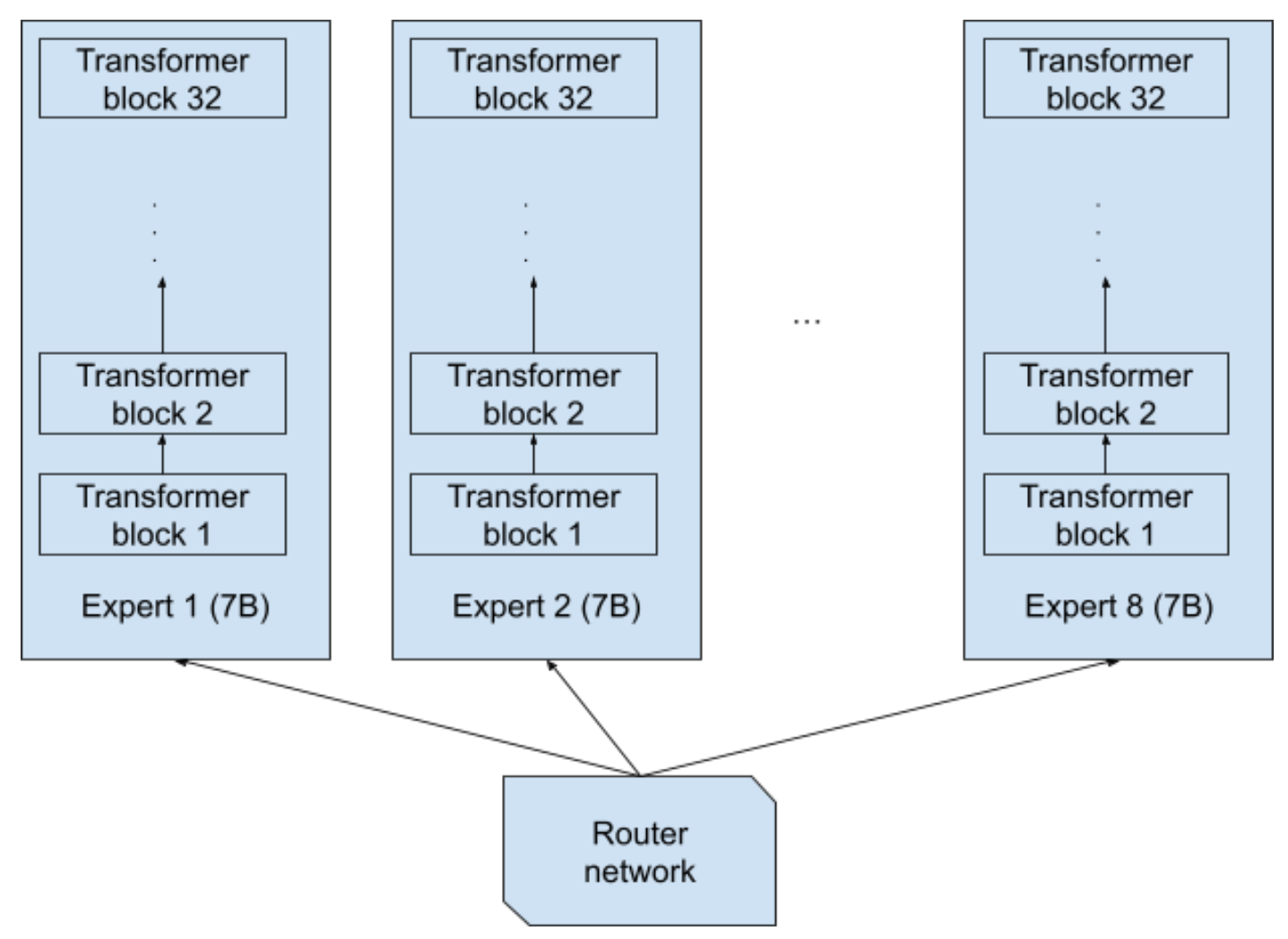

JIUTIAN-139MoE是一个拥有130亿参数的大型语言模型,使用解码器型的MoE架构,包含一对大专家和六个小专家。模型支持在不同GPU和NPU集群上训练,并能无损切换。在FFN层采用MoE设计,有特殊的激活和路由机制。

JIUTIAN-139MoE是一个拥有130亿参数的大型语言模型,使用解码器型的MoE架构,包含一对大专家和六个小专家。模型支持在不同GPU和NPU集群上训练,并能无损切换。在FFN层采用MoE设计,有特殊的激活和路由机制。

## 算法原理

## 算法原理

JIUTIAN-139MoE利用Mixture-of-Experts (MoE) 架构,通过不同规模的专家网络处理不同的数据特征,并通过门控机制智能地分配任务给最合适的专家,从而提高模型处理复杂问题的能力。

JIUTIAN-139MoE利用Mixture-of-Experts (MoE) 架构,通过不同规模的专家网络处理不同的数据特征,并通过门控机制智能地分配任务给最合适的专家,从而提高模型处理复杂问题的能力。

## 环境配置

## 环境配置

...

...

Write

Preview

Markdown

is supported

0%

Try again

or

attach a new file

.

Attach a file

Cancel

You are about to add

0

people

to the discussion. Proceed with caution.

Finish editing this message first!

Cancel

Please

register

or

sign in

to comment