modify readme.md

Showing

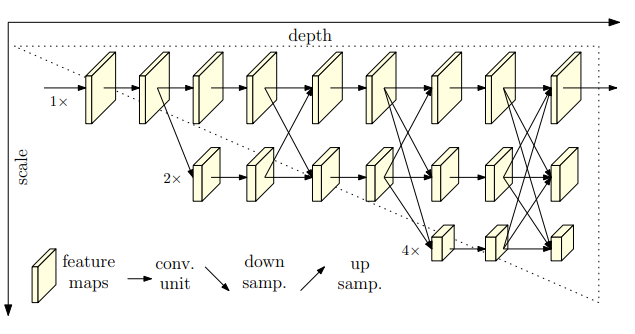

hrnet_1.jpg

0 → 100644

37.5 KB

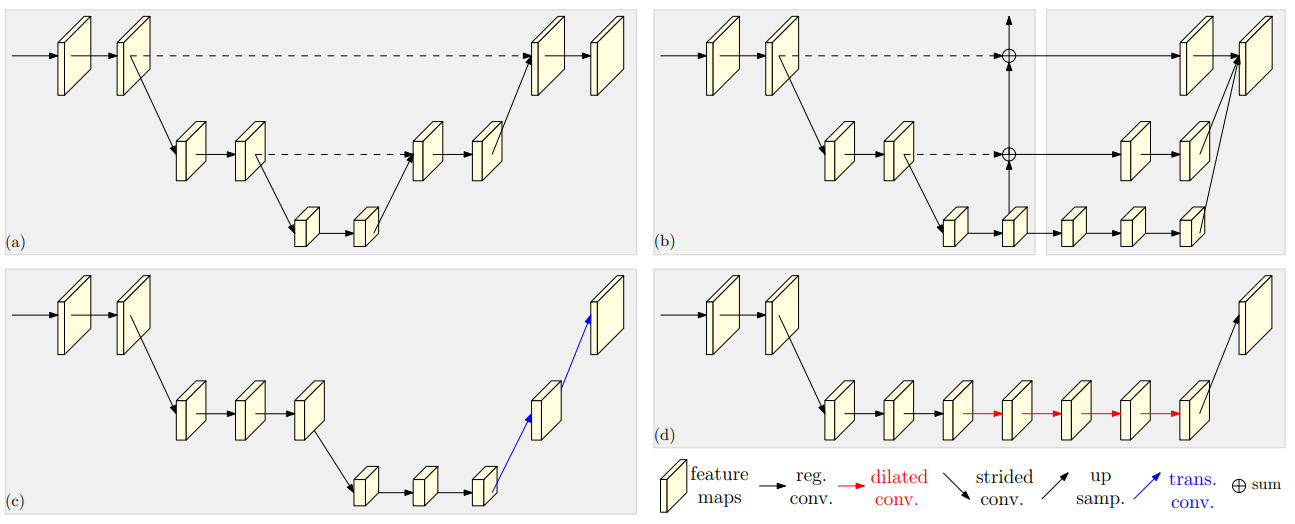

hrnet_2.jpg

0 → 100644

63.5 KB

requirements.txt

100755 → 100644

| -r requirements/build.txt | xtcocotools==1.13 | ||

| -r requirements/runtime.txt | json-tricks==3.16.1 | ||

| -r requirements/tests.txt | munkres==1.1.4 | ||

| -r requirements/optional.txt | matplotlib-inline==0.1.6 | ||

| chumpy==0.70 |

requirements_old.txt

0 → 100755