提交GPT2模型的python和C++代码示例

Showing

3rdParty/InstallRBuild.sh

0 → 100644

File added

File added

File added

File added

File added

File added

CMakeLists.txt

0 → 100644

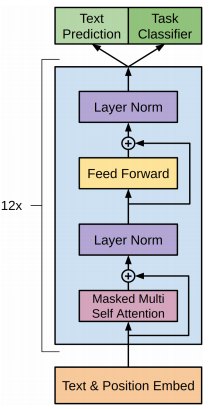

Doc/Images/GPT_01.png

0 → 100644

28.5 KB

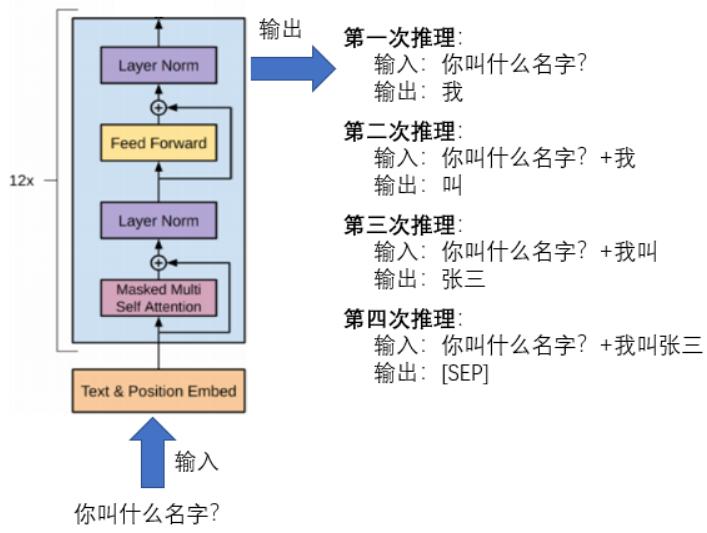

Doc/Images/GPT_02.png

0 → 100644

104 KB

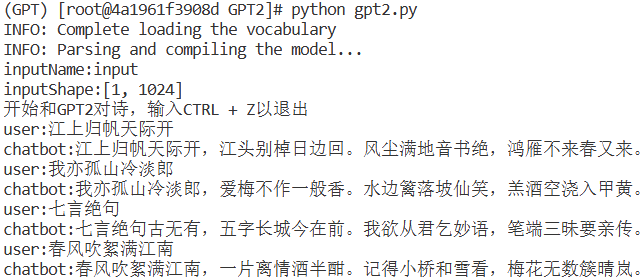

Doc/Images/GPT_03.png

0 → 100644

31.4 KB

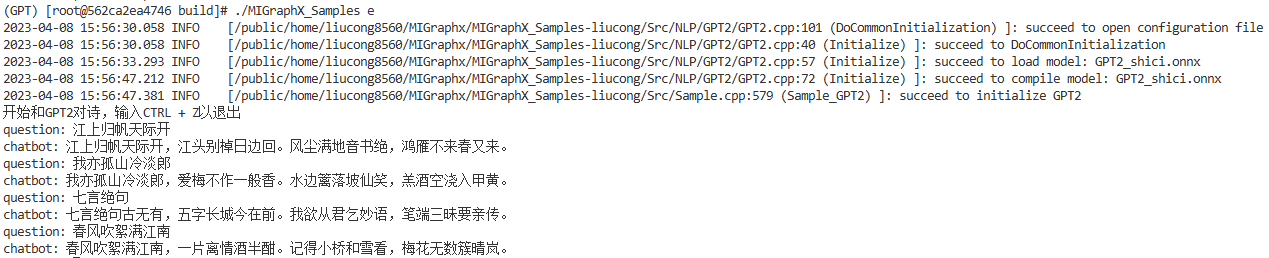

Doc/Images/GPT_04.png

0 → 100644

35.8 KB

Doc/Tutorial_Cpp/GPT2.md

0 → 100644

Doc/Tutorial_Python/GPT2.md

0 → 100644

Python/NLP/GPT2/gpt2.py

0 → 100644

Resource/Configuration.xml

0 → 100644

This diff is collapsed.