first commit

Showing

.gitmodules

0 → 100644

docker/Dockerfile

0 → 100644

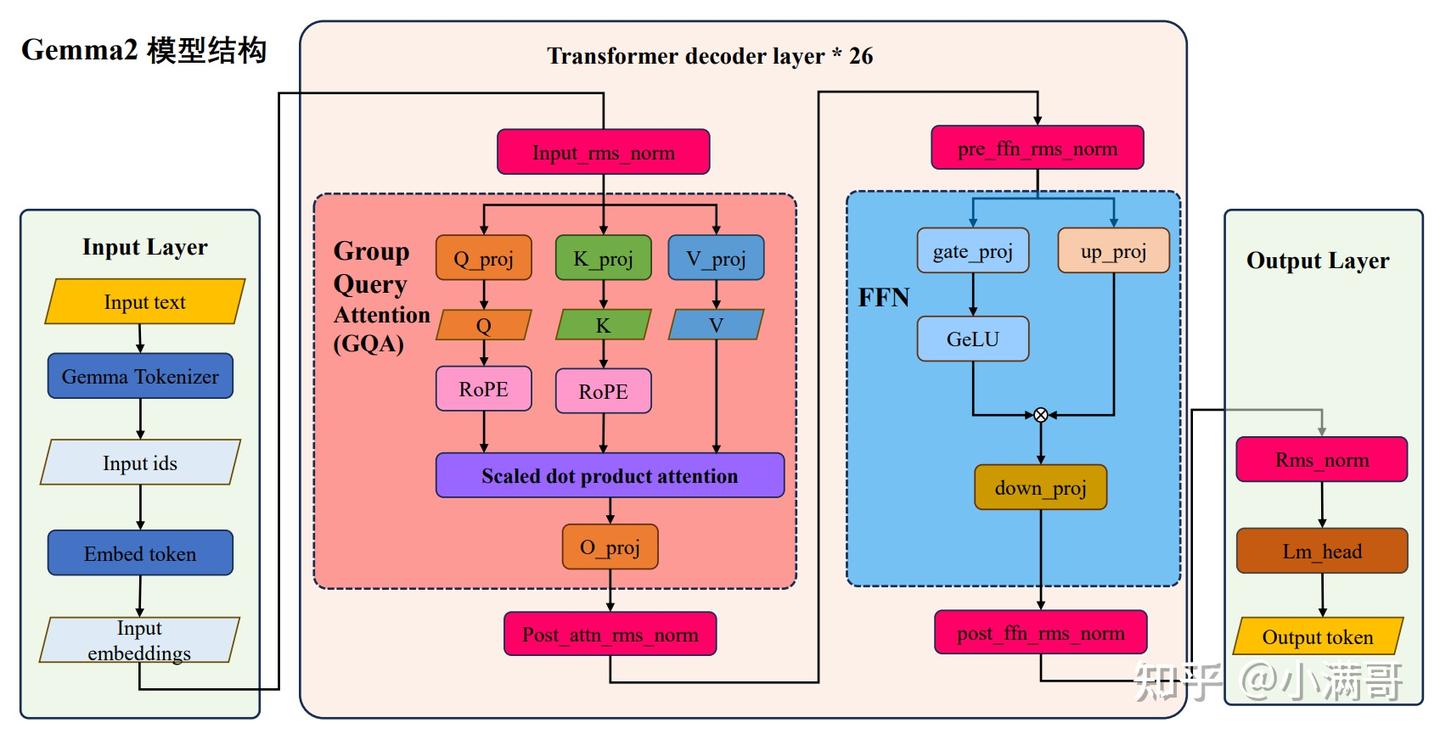

docs/gemma2.jpg

0 → 100644

114 KB

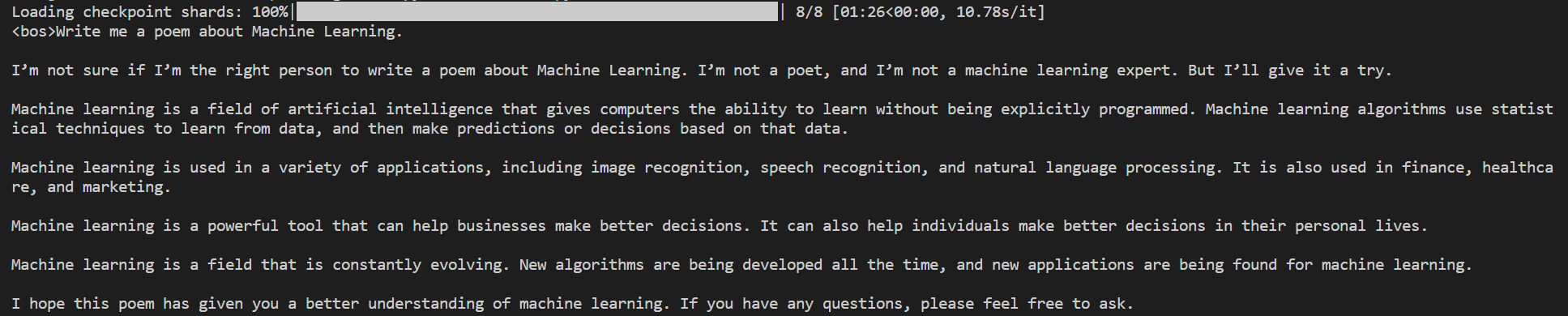

docs/results.png

0 → 100644

54.7 KB

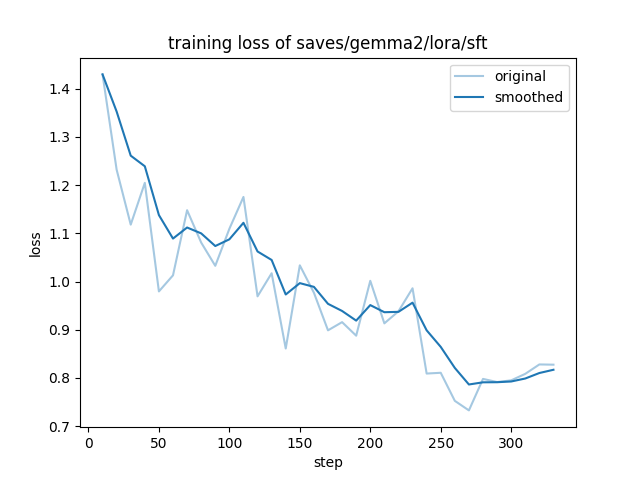

docs/training_loss.png

0 → 100644

39.4 KB

inference.py

0 → 100644

requirements.txt

0 → 100644

| transformers>=4.41.2 | |||

| \ No newline at end of file |