精简代码

Showing

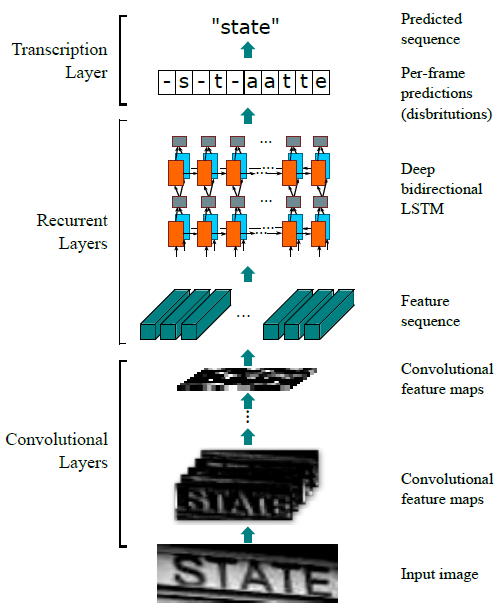

Doc/CRNN_01.jpg

0 → 100644

58.4 KB

Doc/Tutorial_Cpp.md

0 → 100644

Doc/Tutorial_Python.md

0 → 100644

187 KB

198 KB

1.91 KB

117 KB

476 KB

912 KB

143 KB

160 KB

263 KB

5.51 KB

10.2 KB

File deleted

85.1 KB