init chatglm

Showing

.gitmodules

0 → 100644

Dockerfile

0 → 100644

LICENSE

0 → 100644

README.md

0 → 100644

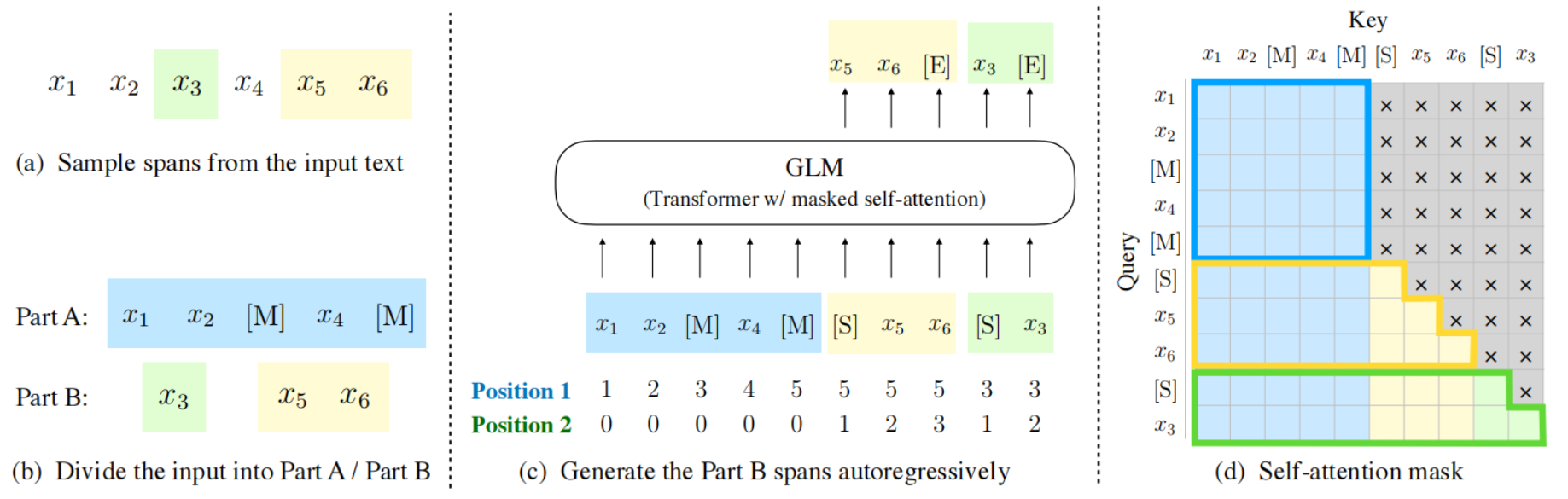

docs/GLM.png

0 → 100644

261 KB

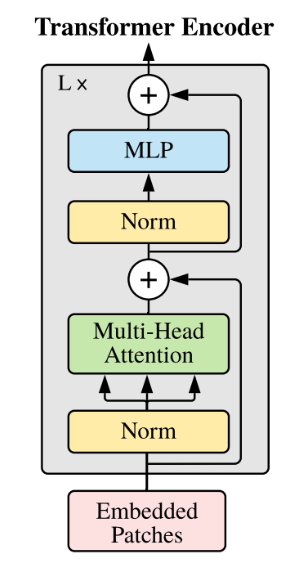

docs/transformers.jpg

0 → 100644

32.7 KB

model.properties

0 → 100644

vllm @ df6349c7