"vscode:/vscode.git/clone" did not exist on "f772fbc9624b4dfee307abbe38c5e976409042ef"

Merge branch 'develop' into 'master'

Develop See merge request !1

Showing

3rdParty/InstallRBuild.sh

0 → 100644

File added

File added

File added

File added

File added

File added

CMakeLists.txt

0 → 100644

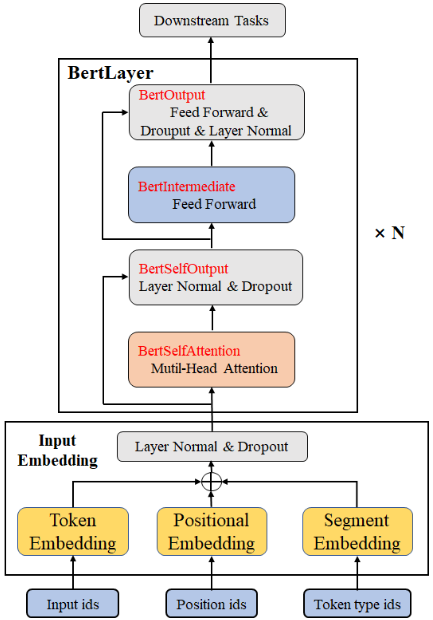

Doc/Images/Bert_01.png

0 → 100644

62.8 KB

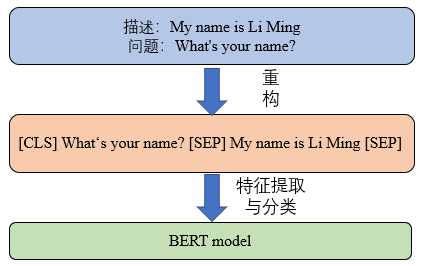

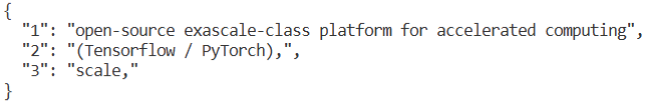

Doc/Images/Bert_02.png

0 → 100644

10.2 KB

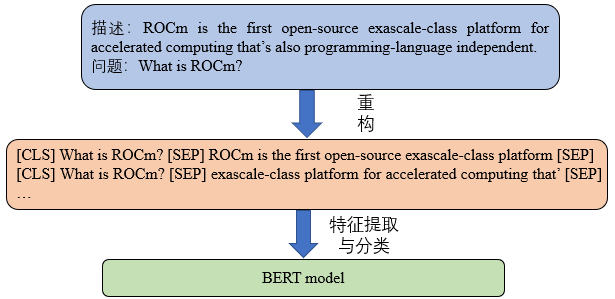

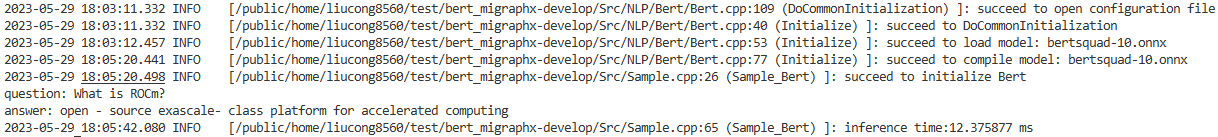

Doc/Images/Bert_03.png

0 → 100644

19 KB

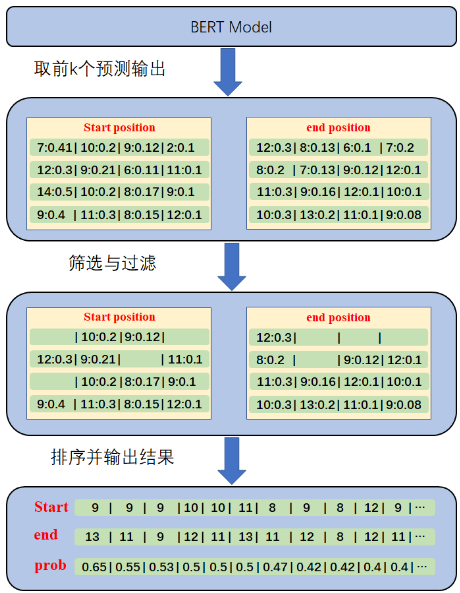

Doc/Images/Bert_04.png

0 → 100644

74.7 KB

Doc/Images/Bert_05.png

0 → 100644

15.2 KB

Doc/Images/Bert_06.png

0 → 100644

26.7 KB

Doc/Tutorial_Cpp/Bert.md

0 → 100644

Doc/Tutorial_Python/Bert.md

0 → 100644