"tests/vscode:/vscode.git/clone" did not exist on "d217278ccbd1554c228f6b208e1fa3de608b44ae"

调整为modelzoo格式

Showing

README.md.bak

0 → 100644

bert.png

0 → 100644

112 KB

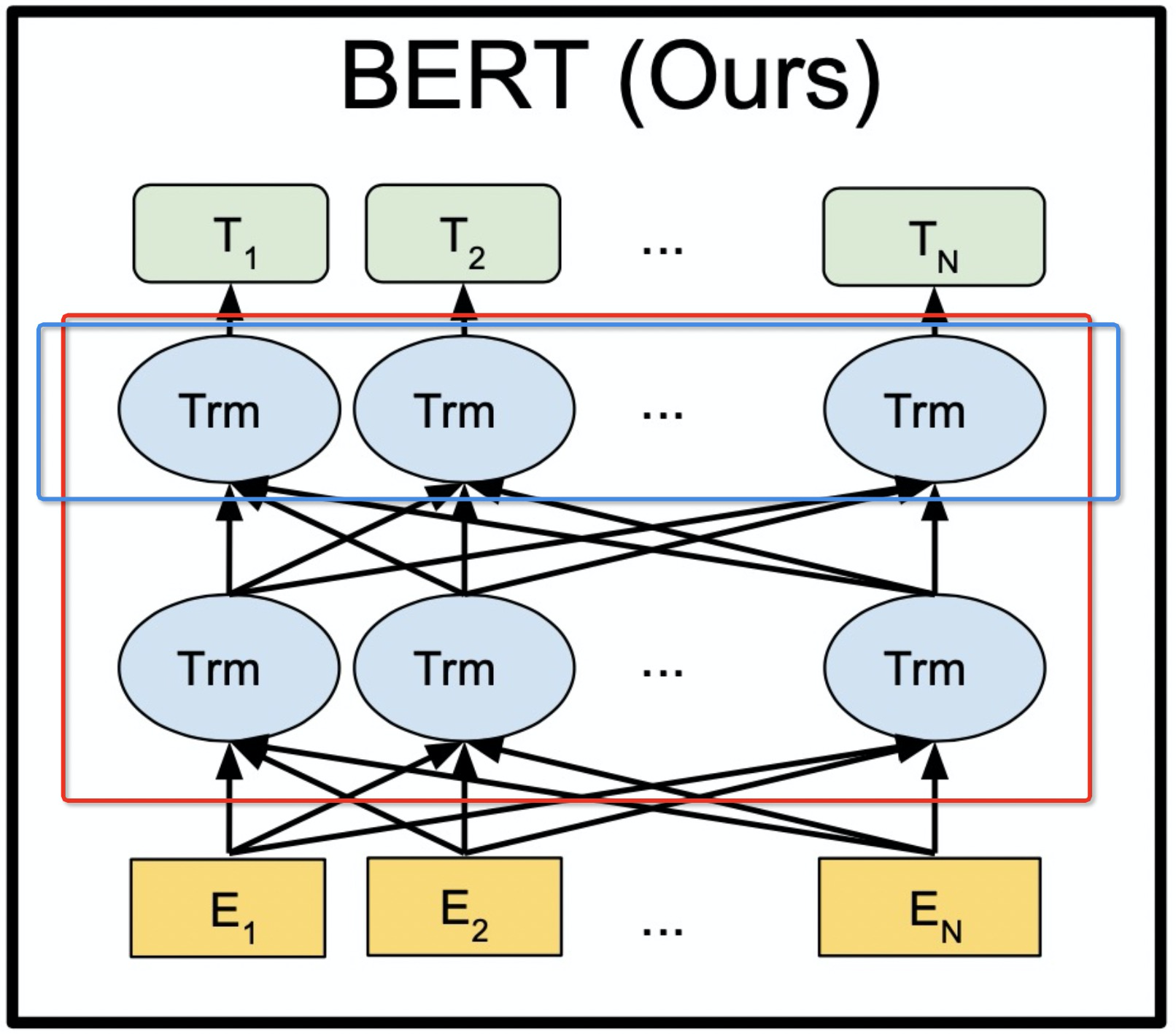

bert_model.png

0 → 100644

791 KB

model.properties

0 → 100644