更改格式。

Showing

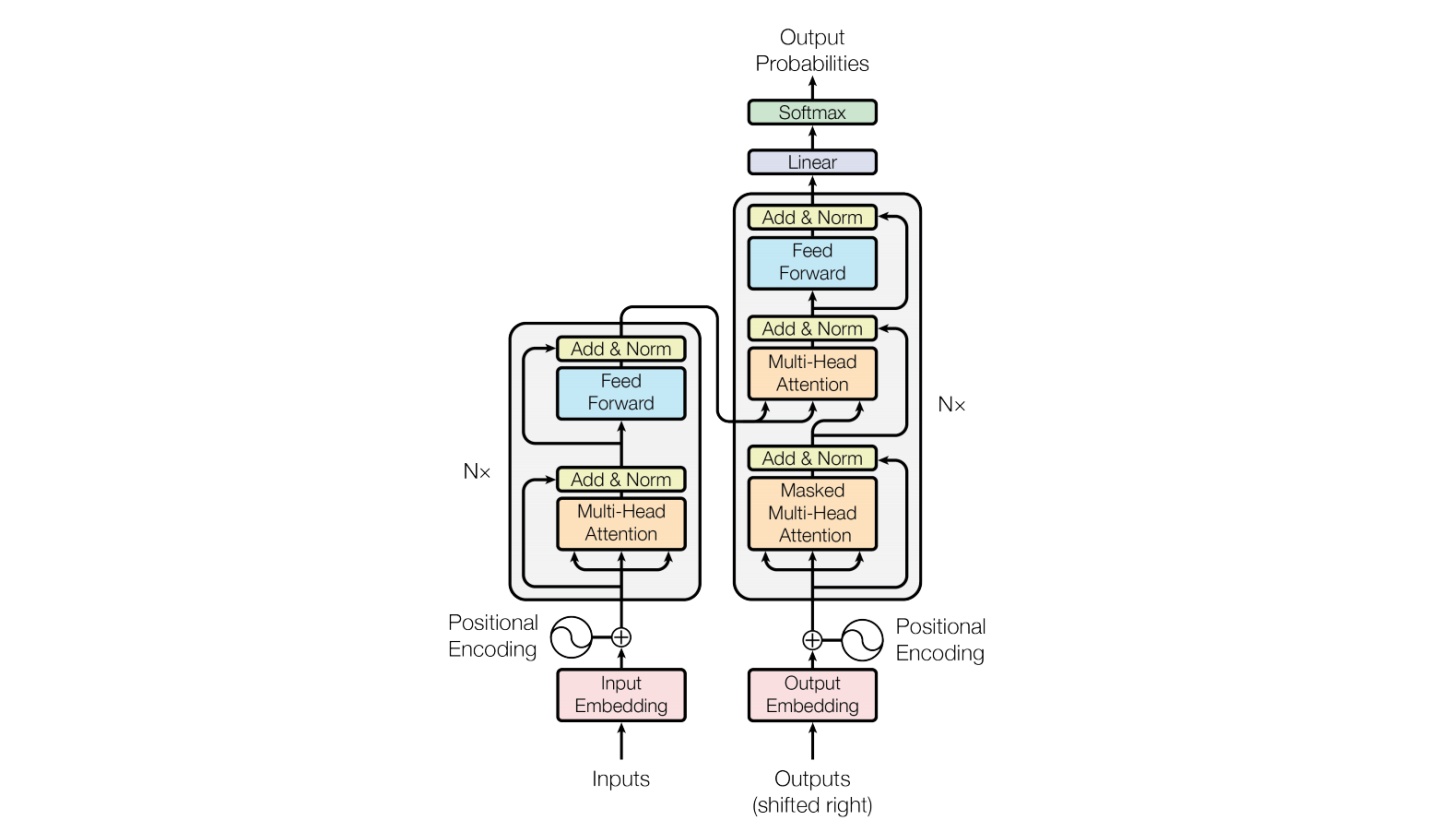

assets/transformer.jpg

0 → 100644

87.9 KB

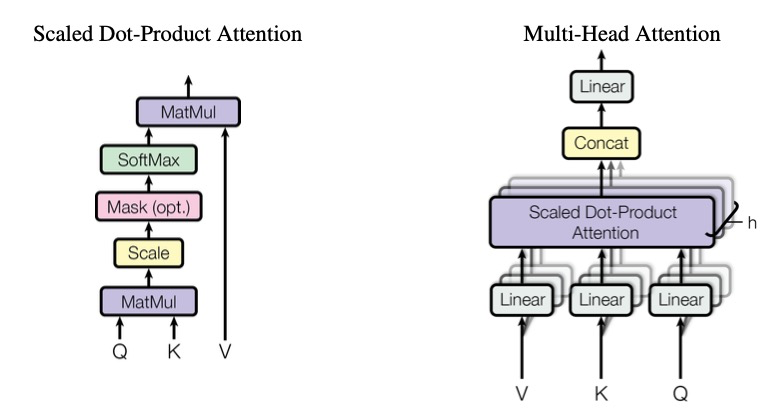

assets/transformer.png

0 → 100644

112 KB

multi_node/deepspeed.json

0 → 100644

multi_node/hostfile

0 → 100644

multi_node/run-13b-sft.sh

0 → 100644