Merge pull request #233 from microsoft/master

merge master

Showing

docs/en_US/pruners.rst

0 → 100644

docs/en_US/quantizers.rst

0 → 100644

36.1 KB

221 KB

125 KB

16.1 KB

54.4 KB

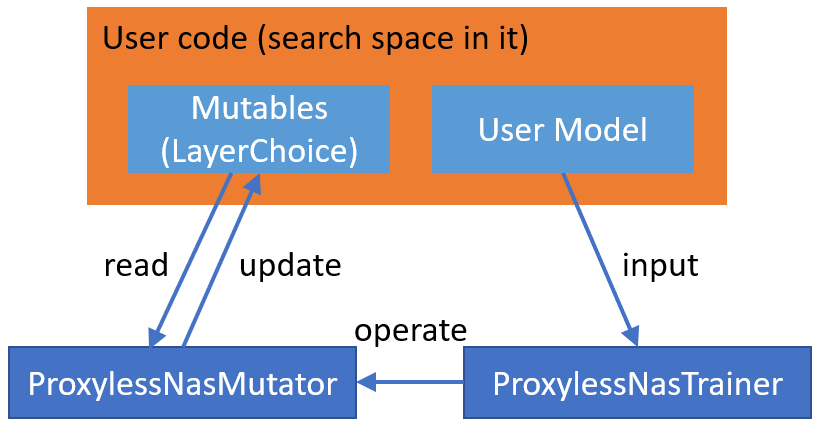

docs/img/proxylessnas.png

0 → 100644

26.3 KB

docs/zh_CN/NAS/Advanced.md

0 → 100644

docs/zh_CN/NAS/NasGuide.md

0 → 100644