Merge pull request #242 from microsoft/master

merge master

Showing

| W: | H:

| W: | H:

docs/zh_CN/NAS/TextNAS.md

0 → 100644

docs/zh_CN/Tuner/PBTTuner.md

0 → 100644

merge master

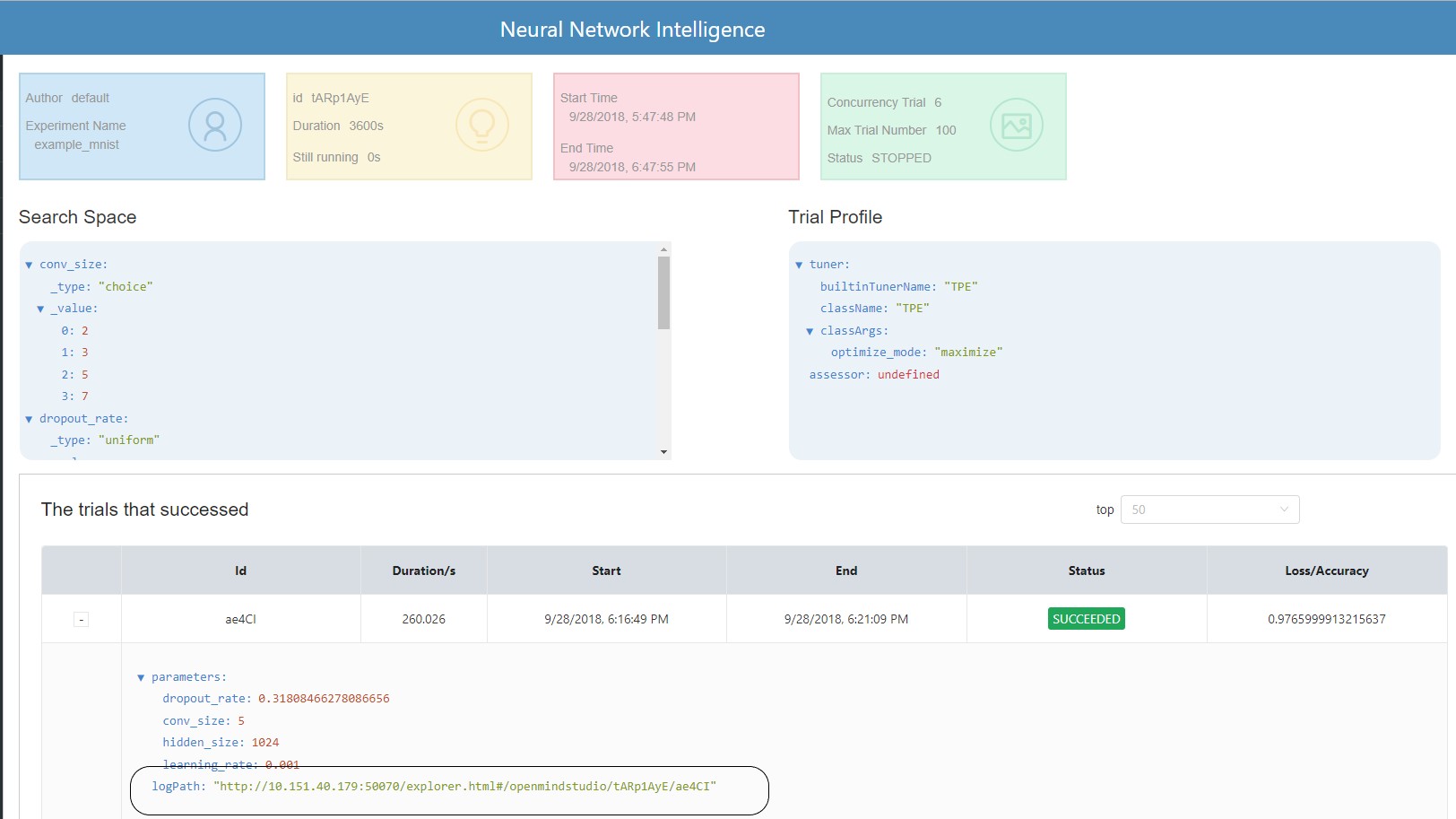

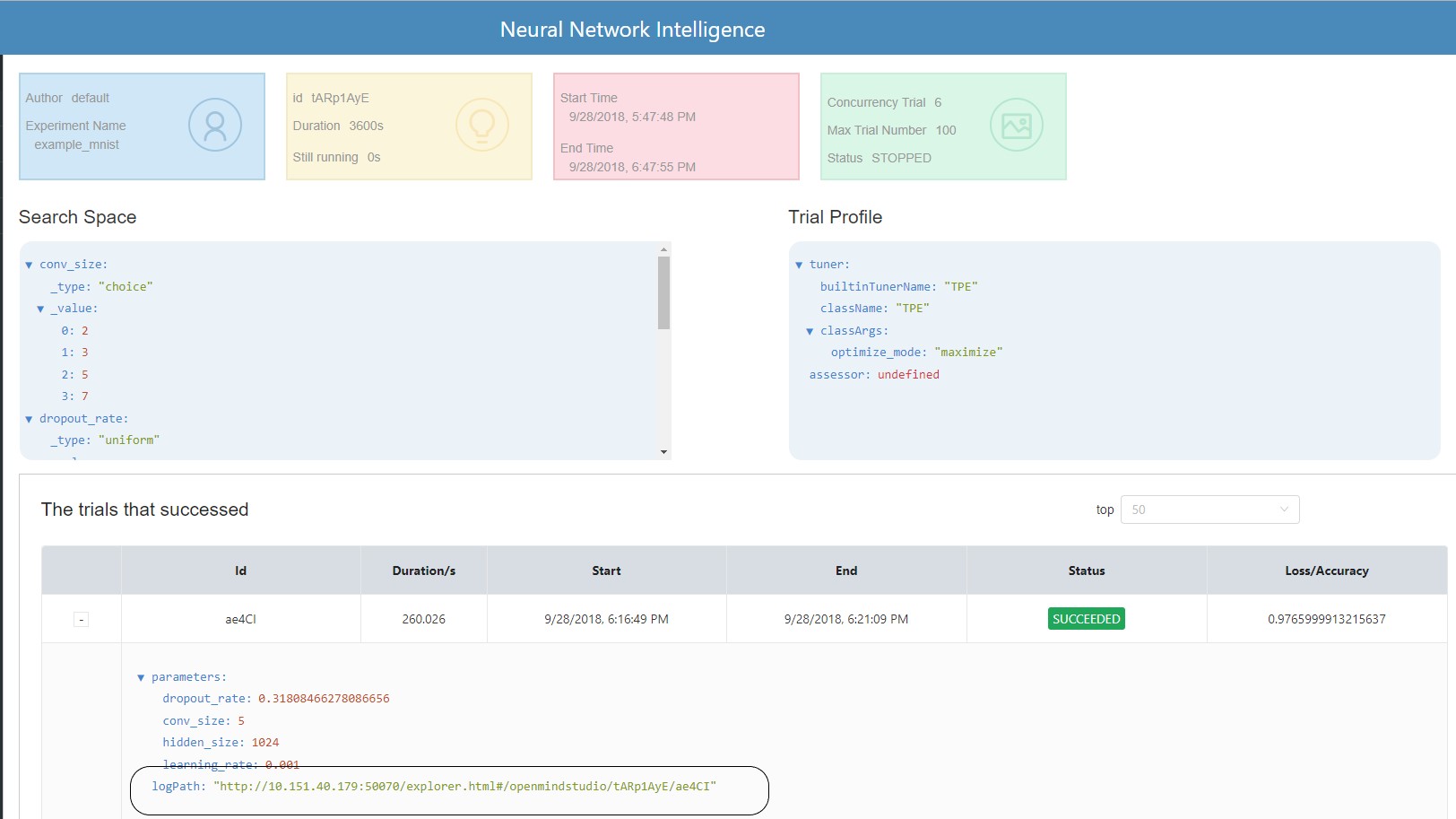

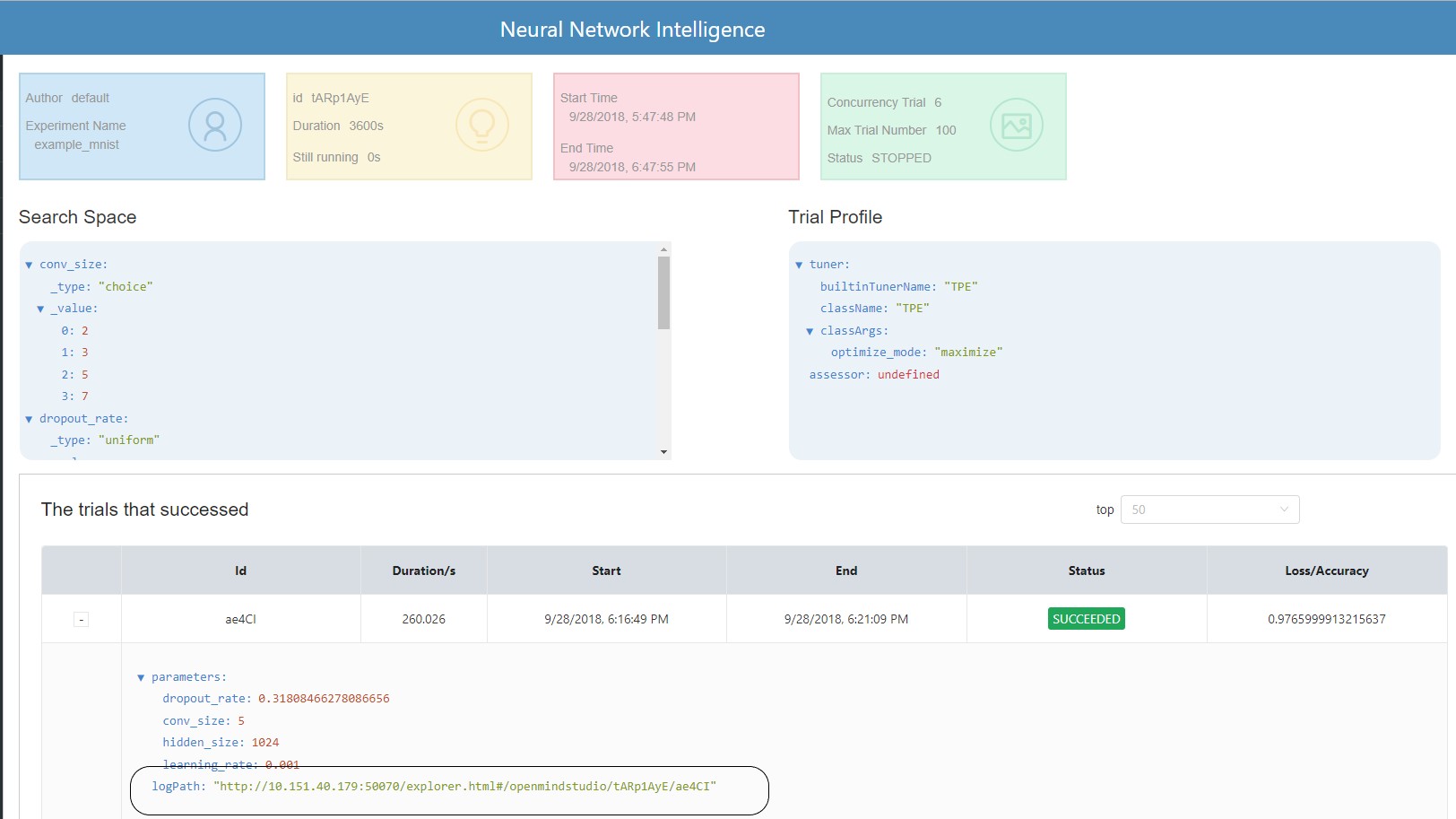

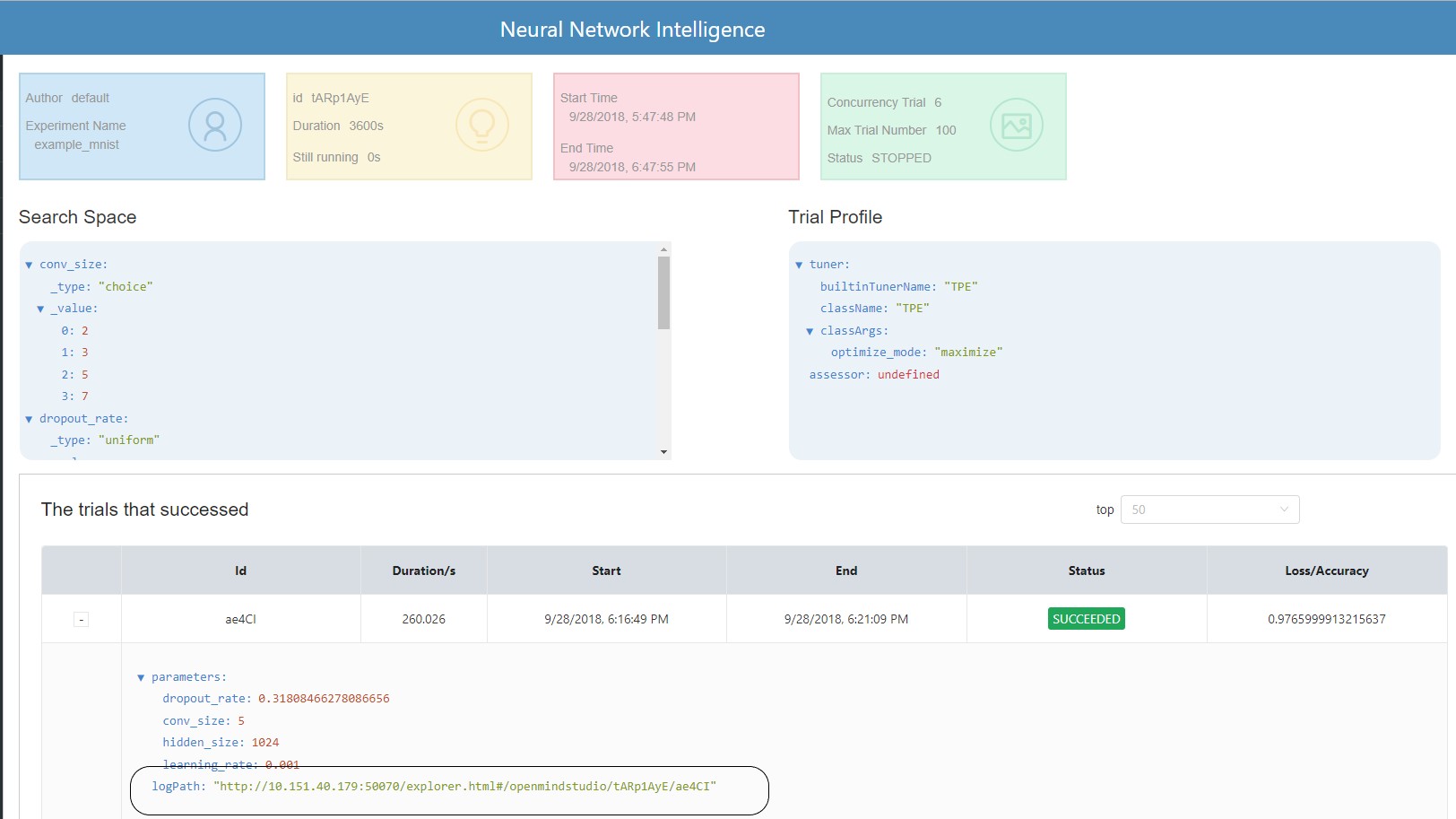

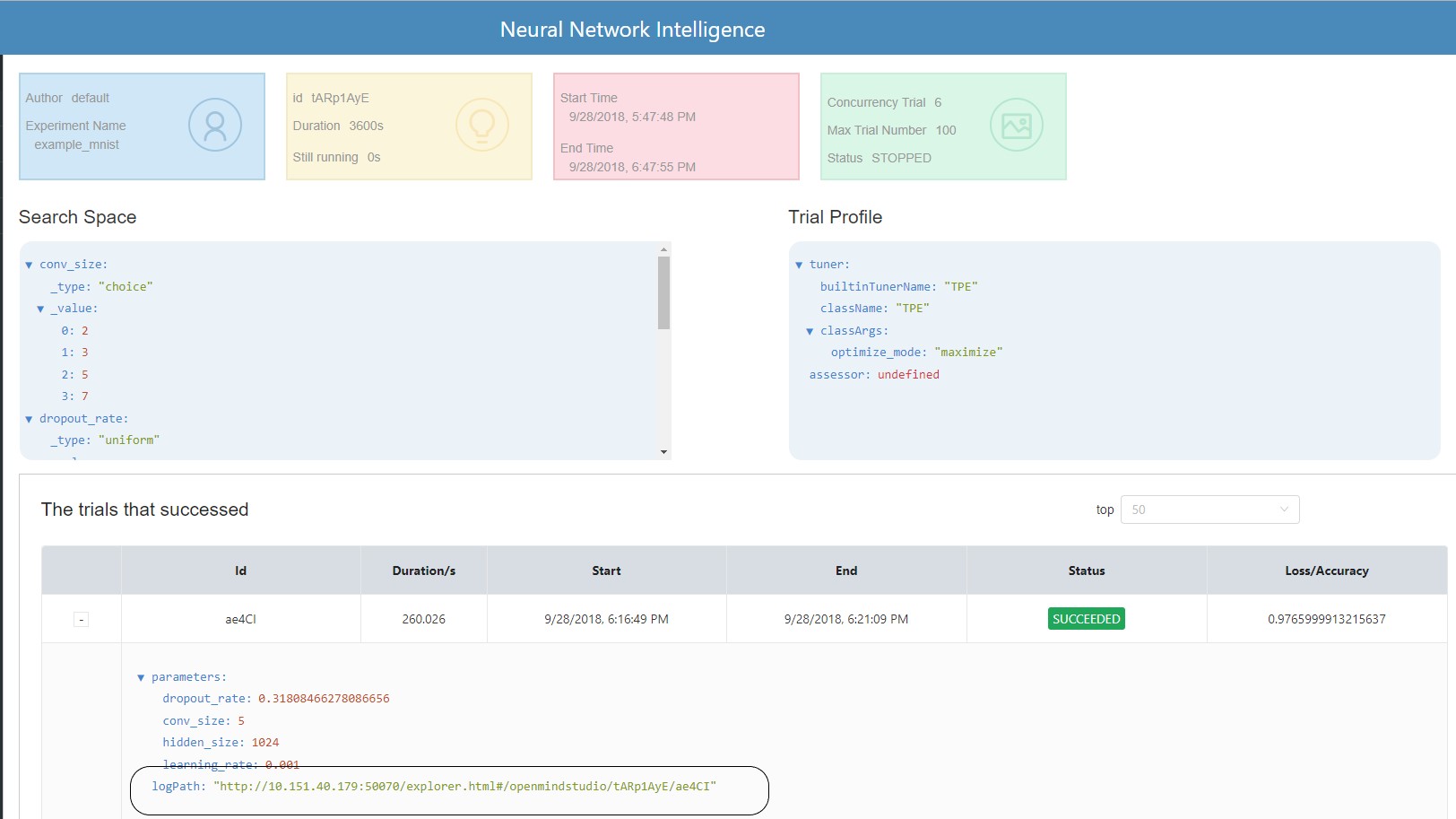

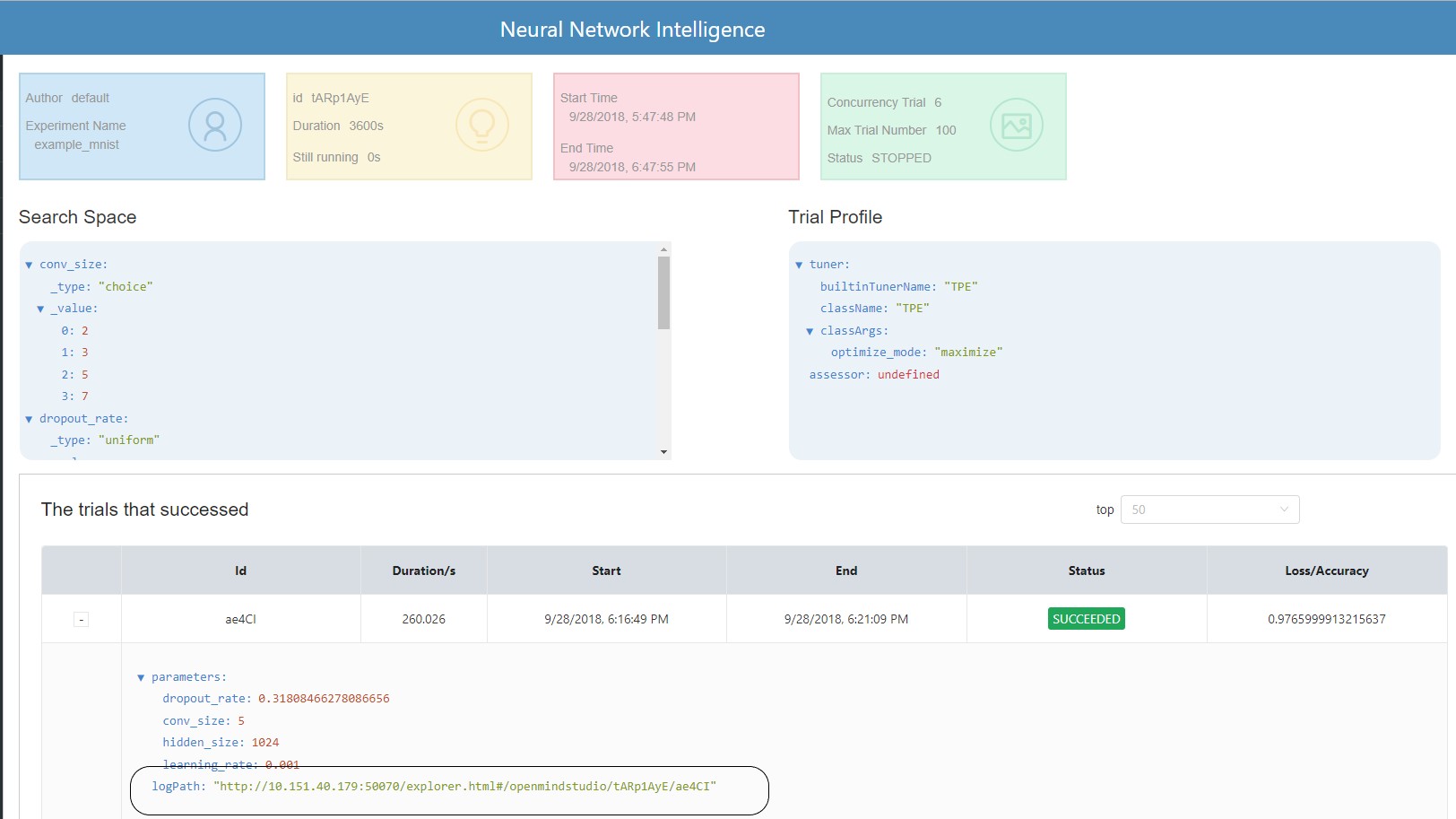

130 KB | W: | H:

130 KB | W: | H: