docs(quantization): add more test (#53)

* docs(quantization): add more test * revert(generate.sh): revert ninja * revert(llama_config.ini): revert empty line * fix(quantization.md): fix link error

Showing

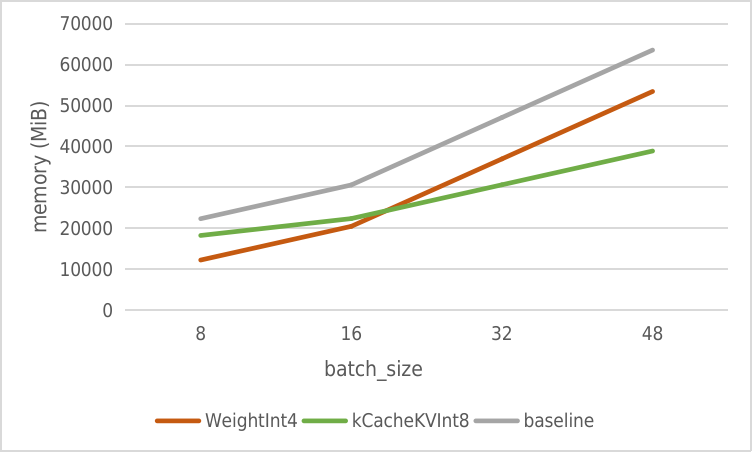

resources/batch_memory.png

0 → 100644

40.5 KB