update README

Showing

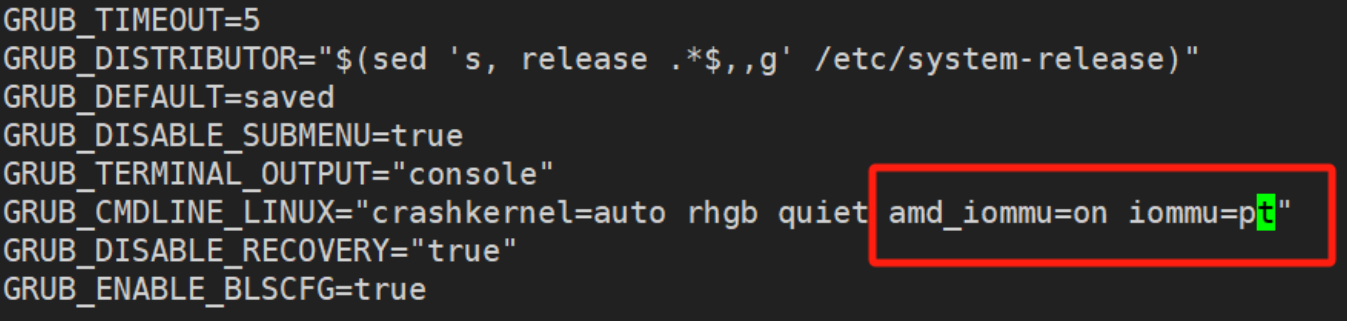

figures/amd_iommu.png

0 → 100644

127 KB

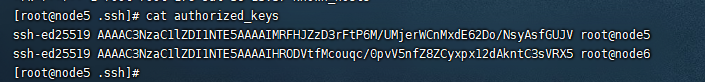

figures/id_rsa.png

0 → 100644

82.7 KB

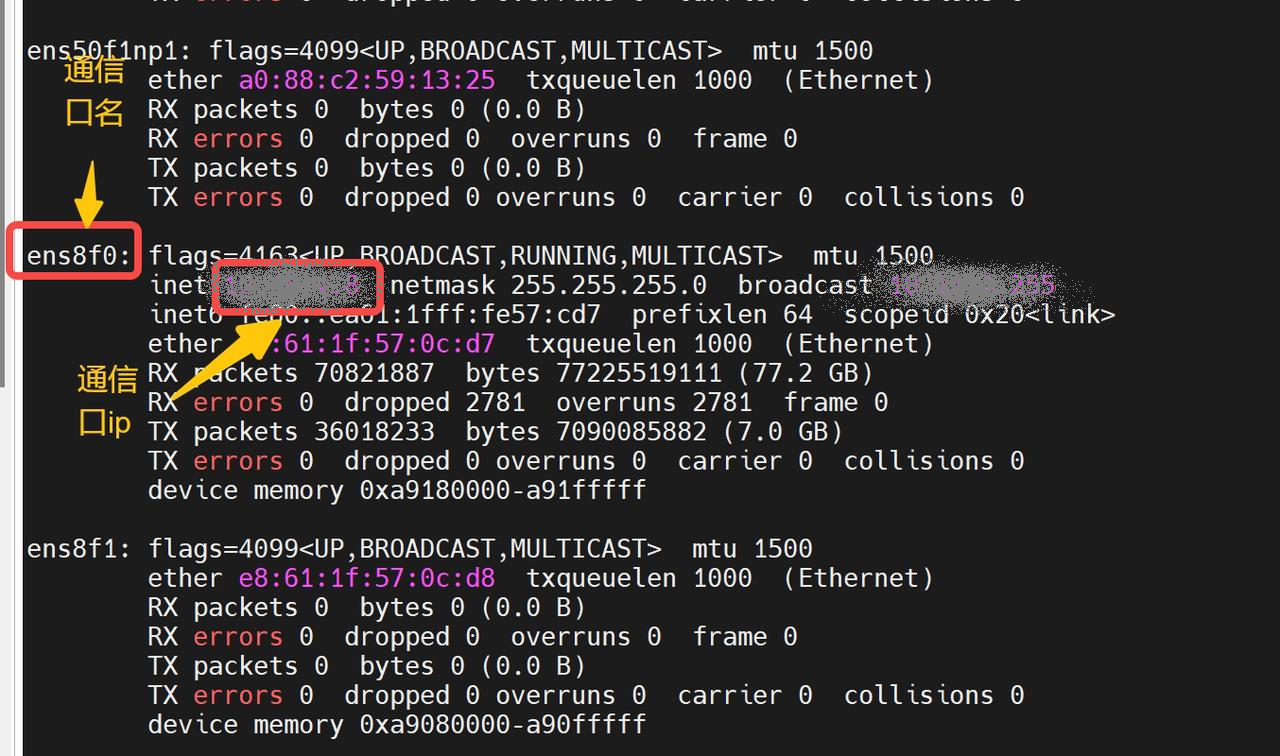

figures/ip.png

0 → 100644

1.06 MB

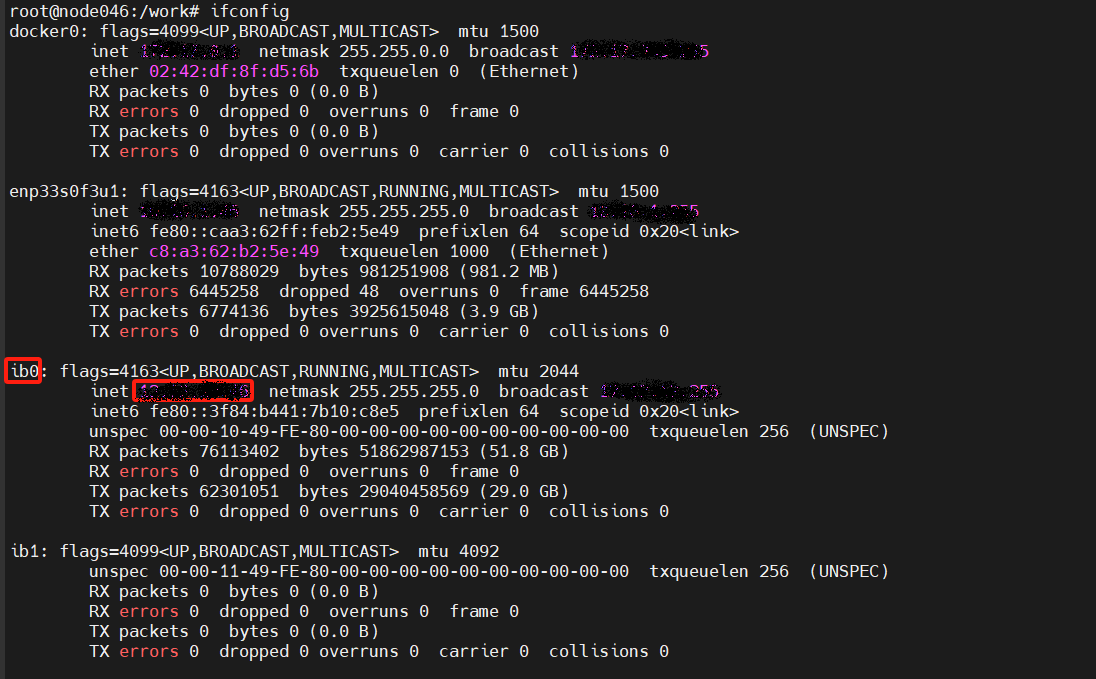

figures/ip_bw.png

0 → 100644

97.1 KB

127 KB

82.7 KB

1.06 MB

97.1 KB