Merge pull request #19 from microsoft/master

pull code

Showing

59.6 KB

44.7 KB

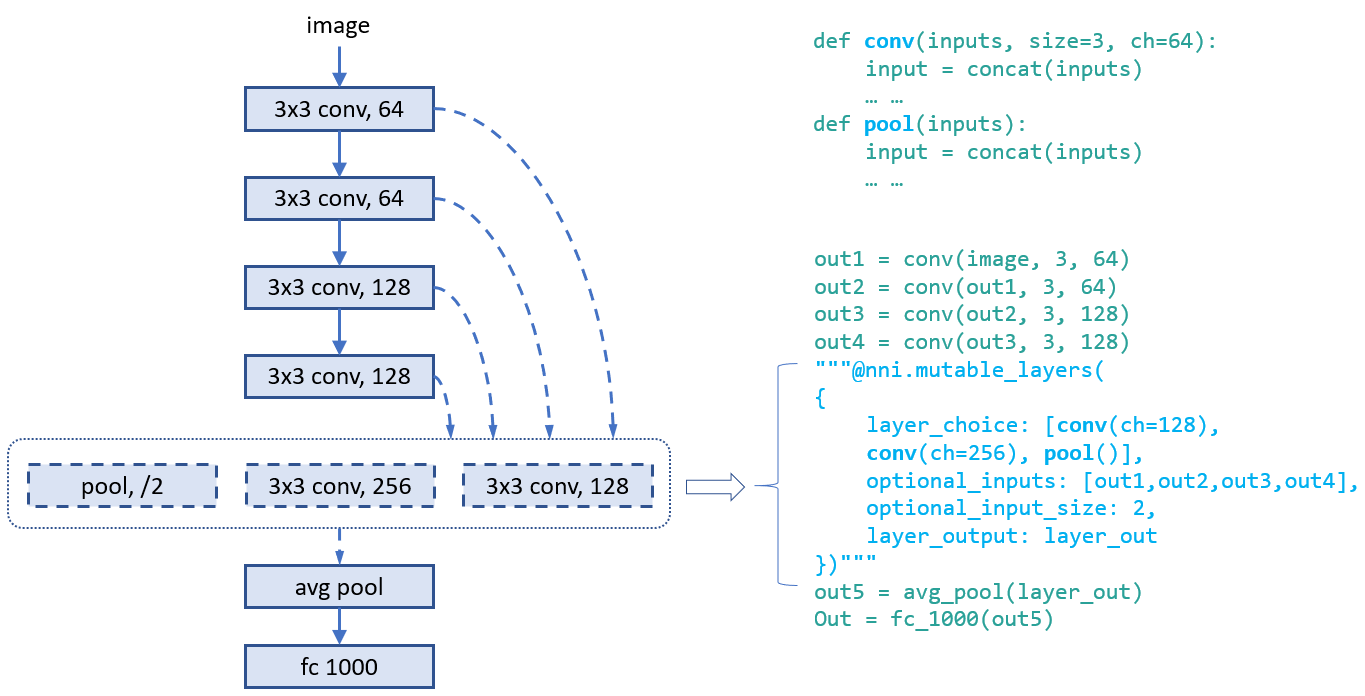

docs/img/example_enas.png

0 → 100644

133 KB

58.6 KB

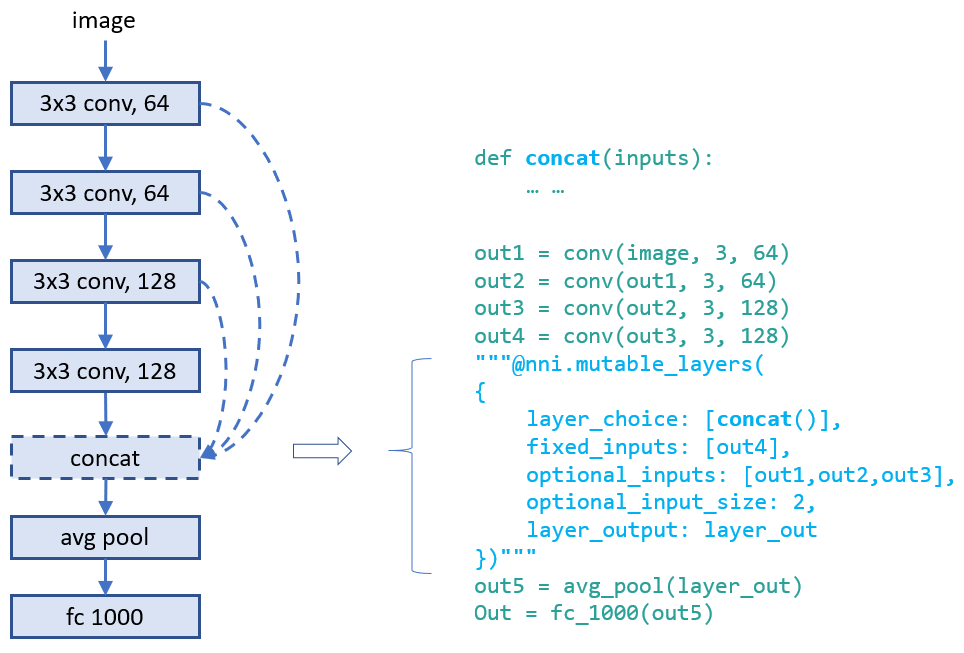

docs/img/nas_on_nni.png

0 → 100644

40.1 KB

28.9 KB

22.9 KB

26.2 KB

33.5 KB

| W: | H:

| W: | H: