Merge pull request #121 from Microsoft/master

merge master

Showing

zh_CN/docs/Trials.md

0 → 100644

zh_CN/docs/Tutorials.rst

0 → 100644

zh_CN/docs/WebUI.md

0 → 100644

zh_CN/docs/advanced.rst

0 → 100644

zh_CN/docs/assessors.rst

0 → 100644

zh_CN/docs/conf.py

0 → 100644

zh_CN/docs/gbdt_example.md

0 → 100644

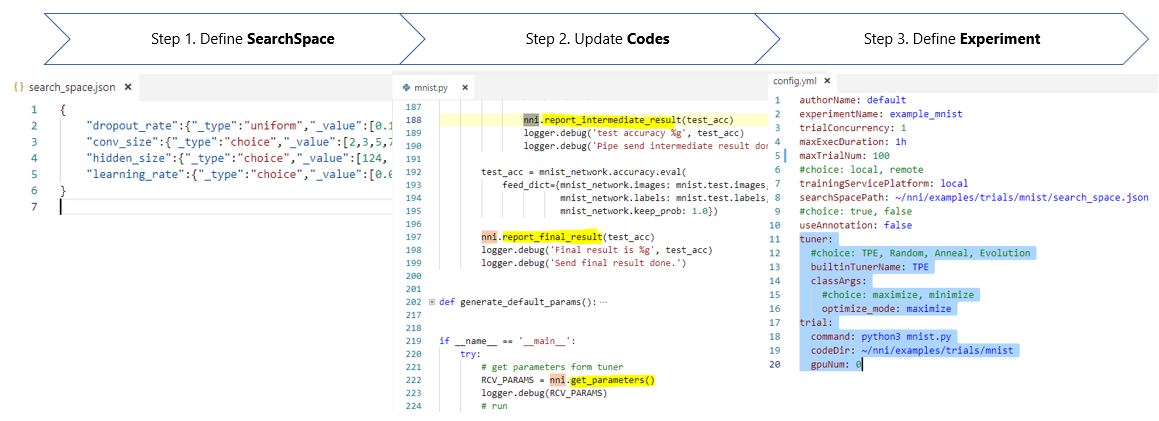

zh_CN/docs/img/3_steps.jpg

0 → 100644

77.7 KB

zh_CN/docs/img/Assessor.png

0 → 100644

119 KB

162 KB

67.6 KB

92.2 KB

292 KB

71.5 KB

118 KB